1.

Einleitung ^

«Die Frage, ob Legal Chatbots bald Rechtsanwälte ersetzen, würde ich persönlich mit Nein beantworten. Sie werden aber immer grössere Teile der Arbeit eines Rechtsanwalts übernehmen. 1»

Obiges Zitat zeigt eindrücklich, dass Chatbots in der Zukunft auch im Bereich der Rechtsberatung eine immer wichtigere Rolle spielen werden. Es haben sich bereits diverse Anbieter auf nationaler und internationaler Ebene positioniert, welche eine Rechtsberatung mittels Chatbot offerieren. In der Schweiz bietet namentlich «Justus»2 bei strafrechtlichen Fragen unverbindlichen Rat, während der Verein «Legal Help» einen Chatbot einsetzt, welcher den Erstkontakt mit dem Klienten abdeckt.3 Auch im Ausland existiert bereits eine grosse Anzahl von Angeboten. Die Deutsche Bundesverwaltung stellt einen Chatbot bereit, welcher die Bevölkerung bei Fragen rund um Corona berät4 und im amerikanischen Markt bietet «DoNotPay»5 bereits eine Vielzahl von Leistungen an. Dort kann mittels Chatbot u.a. direkt eine Beschwerde gegen eine Parkbusse eingereicht werden. Ausserdem haben sich bereits Softwareentwickler auf die Erstellung von Chatbots spezialisiert.6 Im Kontext dieser Entwicklungen wurde jedoch von der juristischen Praxis bisher nicht geklärt, inwiefern der Anbieter eines solchen Chatbots haftungsrechtlich belangt werden könnte, wenn der von ihm verwendete Chatbot eine fehlerhafte Auskunft erteilt und es infolgedessen zu einem Schaden kommt. Zu diesem Zweck wird hier folgende Frage aufgeworfen: Inwiefern bestehen für das Anbieten einer automatisierten Rechtsberatung mittels Chatbot haftungsrechtliche Risiken?

Methodisch wird in einem ersten Schritt eine Abgrenzung zwischen einem System mit künstlicher Intelligenz und einem rein regelbasiertem Expertensystem vorgenommen. In diesem Bereich werden auch die mit der künstlichen Intelligenz verbundenen Begriffe erläutert. Im Anschluss wird die Funktionsweise der Chatbots analysiert. Zudem werden die Chatbots in diesem Abschnitt dogmatisch nach dem Kriterium der «Autonomie» und der «Unsicherheit des Outputs» in drei Typen unterteilt. In einem zweiten Schritt erfolgt auf Basis der Erkenntnisse im technischen Bereich eine juristische Analyse der haftungsrechtlichen Fragen. In der juristischen Analyse wird untersucht, welches Vertragsverhältnis zwischen dem Chatbot-Betreiber und dem Klienten bestehen könnte. Im Anschluss wird exemplarisch die Haftung für den Chatbot-Betreiber nach dem Auftragsrecht anhand der hier vorgenommenen Typisierung der Chatbots untersucht.

2.

Bestimmung des Begriffs der künstlichen Intelligenz (KI) und deren Abgrenzung von einem rein regelbasierten Expertensystem ^

Damit später eine haftungsrechtliche Analyse der Chatbots7 erfolgen kann, wird hier in einem ersten Schritt der Begriff der künstlichen Intelligenz (nachfolgend KI)8 aus technischer Sicht analysiert und von sogenannten regelbasierten Expertensystemen abgegrenzt.9 Diese Unterscheidung ist für die durchgeführte Analyse von besonderer Wichtigkeit, da in einem ersten Schritt die regelbasierten Expertensysteme (Chatbot Typ 1, vgl. hierzu Kap.3.1) haftungsrechtlich betrachtet werden. In einem zweiten Schritt erfolgt die Analyse der künstlich intelligenten Systeme (Chatbot Typ 2 und 3, vgl. hierzu Kap. 3.2 f.).

2.1.

Der Versuch einer Definition des Begriffs der KI ^

Bei einer Betrachtung der Fachliteratur fällt sehr schnell auf, dass grundsätzlich keine allgemein gültige Definition von KI besteht.10 Eine mögliche Definition lautet wie folgt: Als künstlich intelligent werden Systeme bezeichnet, welche (zumindest) eine Illusion eines intelligenten Verhaltens erzeugen, auch wenn sich diese Intelligenz nur auf einen sehr engen Bereich der menschlichen Intelligenz beschränkt.11 Diese Beschreibung allein vermag jedoch den technischen Gehalt einer KI nicht vollständig zu umschreiben.

2.2.

Die grundlegende Funktionsweise einer KI ^

Die zugrunde liegende Funktionsweise einer KI ist ein Algorithmus,12 also eine in «Einzelschritte zerlegte Handlungsanweisung zur Lösung einer bestimmten Aufgabenstellung».13 Ein sogenannter deterministischer Algorithmus zeichnet sich gerade dadurch aus, dass er bei Eingabe des gleichen Inputs auch immer zum gleichen Output bzw. zur gleichen Entscheidung gelangt.14 Das Vorhandensein eines Algorithmus genügt jedoch noch nicht, um das System als KI einzustufen, vielmehr ist hier der Einbezug des Machine Learnings (ML) nötig.15 Machine Learning bezweckt, dass ein lernender Algorithmus aus Erfahrungen ein komplexes statistisches Modell entwickelt, welches dann auf andere dem System bisher unbekannte Daten angewendet werden kann.16 Dieses Modell kann dann Vorhersagen treffen, ohne dass im Voraus alle Berechnungen oder Regeln vorgeben werden müssen.17 Damit sich die Vorhersagekraft eines lernenden Algorithmus erhöht, muss dieser mittels Daten trainiert werden.18, 19 Gemäss Wanger kann das maschinelle Lernen entweder überwacht (supervised learning), unüberwacht (unsupervised learning) oder auch in hybrider Form (semi-supervised) erfolgen.20 Das überwachte Lernen zeichnet sich dadurch aus, dass dem System Trainingsdaten eingegeben werden und die zu den Eingaben gehörenden Labels21 mitgeliefert werden.22 Beim unüberwachten Lernen reichen die Rohdaten aus, um die zugrundeliegenden Muster zu erkennen.23 Die dritte Kategorie stellt das semi-überwachte Lernen dar, welches zu einem Teil aus Trainingsdaten mit Labels besteht, zum anderen aber auch Rohdaten verwendet.24 In diesem Bereich stellt sich die Frage, ob sich das System auch nach Aufnahme des Betriebs (autonom) weiterentwickelt, oder ob die darin enthaltene KI nach Aufnahme der operativen Tätigkeit auf ihrem Entwicklungsstatus verbleibt.25 Eine weitere Entwicklung im Bereich der KI stellt die Bildung von neuronalen Netzwerken dar.26 Diese neuronalen Netzwerke sind dem menschlichen Gehirn nachempfunden und bestehen aus einer Vielzahl hintereinandergeschalteter Algorithmen, welche sich gegenseitig beeinflussen.27

2.3.

Der Unterschied zwischen einer starken und schwachen KI ^

Die Forschung unterscheidet ferner zwischen einer schwachen und starken KI. Auch hier besteht wiederrum die Problematik, dass sich bis zum gegenwärtigen Zeitpunkt keine einheitliche Definition durchgesetzt hat. So versteht namentlich Kriesel unter einer schwachen KI ein System, welches «sich in den Grenzen der jeweiligen Programmierung und im Rahmen eines eng umgrenzten Aufgabenbereichs»28 bewegt. Zudem wird der Nutzungszweck, das zu erreichende Ziel und die Analysevorgaben durch den Menschen bestimmt und können durch das System nicht verändert werden.29, 30 Hinsichtlich der starken KI herrscht unter den Autoren zumindest dahingehend Einigkeit, dass diese in naher Zukunft nicht realisierbar ist.31 Eine starke KI kann den von Entwicklern gesetzten Handlungsrahmen verlassen32 und möglicherweise sogar ein eigenes Bewusstsein entwickeln.33 Im Hinblick auf die hier durchgeführte haftungsrechtliche Analyse stellt sich zudem die Frage, ob die von der KI generierten Antworten erklärbar sind (sog. Explainable AI).34 Gerade im Hinblick auf die Vermeidung von Schäden erscheint es wichtig, dass der Anbieter eines solches Systems dessen Stärken und Schwächen kennt und auch versteht, nach welchen Grundregeln das System funktioniert bzw. wie es in einem Einzelfall zu einer Entscheidung gekommen ist.35 Aus diesem Grund bestehen in der Forschung Bestrebungen, die «Blackbox der KI»36 mittels der Generierung von konkreten Erklärungen zu öffnen.37 Es ist zudem von zentraler Bedeutung, dass die vorgenommenen Entscheidungen der AI Schritt für Schritt rückverfolgbar sind,38 was wiederum bei rechtlichen Beratungsdienstleistungen mit datenschutzrechtlichen Problemen verbunden sein könnte.

2.4.

Abgrenzung einer KI von einem Expertensystem ^

Zum Schluss ist hier eine Abgrenzung der KI zu den rein regelbasierten Expertensystemen vorzunehmen. Bei den Expertensystemen werden bekannte Zusammenhänge und Wissen zur Problemlösung in «computergerechte Regeln und Modelle übersetzt».39 Diese Regeln (in Form von Wenn-Dann-Beziehungen) werden dann zur Bewältigung vorgegebener Probleme und zur Analyse von Datenbeständen eingesetzt.40 Der Vorteil bei dieser Art von Systemen ist, dass im Nachgang genau nachvollzogen werden kann, wie das Resultat (bzw. der Output) zustande gekommen ist, weil die Analyse des Inputs deterministisch nach bekannten Regeln und Schritten abläuft.41

3.

Der Versuch einer Klassifizierung der Chatbots aus einer technischen Perspektive ^

Unter einem Chatbot wird ein «technologiebasiertes Dialogsystem» verstanden, welches «nach bestimmten Regeln oder mit Hilfe künstlicher Intelligenz mit Menschen interagiert, sei es durch Texteingabe oder auch Sprache».42 Diese Chatbots können nun dazu verwendet werden, dem Nutzer eine rechtliche Auskunft zu erteilen.43 Nachfolgend erfolgt eine summarische Darstellung der einzelnen technischen Möglichkeiten, welche genutzt werden können, um ein solches Tool zu realisieren.

3.1.

Typ 1: Der Chatbot mit einem begrenzten Einsatzbereich unter Verwendung eines regelbasierten Systems ^

In dieser Kategorie wird ein regelorientierter Ansatz verfolgt, in welchem die rechtlichen Regeln als Code abgebildet44 und in Form eines Entscheidungsbaumes dargestellt45 werden. Diese Methode funktioniert dann ausgezeichnet, wenn sich die Rechtssätze in einer Wenn-Dann-Beziehung darstellen lassen.46 Die Tatbestandselemente müssen mit einer Ja/Nein-Frage, oder einer begrenzten Anzahl von Auswahlmöglichkeiten beantwortet werden können.47 Der Anwender kann dann jeweils die passende Antwort auswählen und gelangt dann zur Folgefrage, wobei dieser Vorgang so lange wiederholt wird, bis die Rechtsfrage beantwortet ist.48 Die Anwendbarkeit dieses Systems ist vor allem dann eingeschränkt, wenn zur Ermittlung der Rechtsfolge eine umfangreiche Subsumptionsleistung erbracht werden muss49, weshalb diese Methode in einigen Rechtsgebieten nur begrenzt angewendet werden kann.50

3.2.

Typ 2: Der Chatbot mit einem begrenzten Einsatzbereich unter Verwendung von Natural Language Processing und einer regelbasierten oder KI-gestützten Datenanalyse ^

Diese Art von Chatbots funktioniert mit Natural Language Processing (nachfolgend NLP). NLP ist eine Form der künstlichen Intelligenz, welche darauf abzielt, dass das System die menschliche Sprache verstehen, interpretieren und imitieren kann.51 Die genaue Funktionsweise von einem Chatbot dieser Kategorie kann sehr stark variieren. Namentlich beim Blitzbot der Coop Rechtsschutzversicherung wurde der Chatbot mit Tools von IBM erstellt.52 Die zu beantwortenden Fragen wurden hier in einem ersten Schritt in ein Regelwerk abgefasst, welches dann mit Hilfe des NLP-Tools «Conversations»53 unter Verwendung von natürlicher Sprache abgefragt werden kann.54 Darauf aufbauend wurden dann sämtliche vorhandene Daten in das Machine-Learning-Tool «Discovery»55 eingelesen.56 Das Tool wird mit den Daten darauf trainiert, zu den gestellten Fragen des Benutzers die passendsten Textstellen aus den Daten zuzuordnen.57 Mackmood/Bammert/D’Onofrio haben mit Hilfe der Microsoft AI Plattform einen Chatbot für die Schweizer Post entwickelt,58 welcher den Kunden 6 500 Fragen aus 80 verschiedenen Themenbereichen beantworten kann.59 Eben genannte Autoren beschreiben die Wirkungsweise eines Chatbots der hier beschriebenen Kategorie etwas allgemeiner. In einem ersten Schritt wird der vom Benutzer eingegebene Input mittels NLP maschinenlesbar gemacht.60 Danach findet das sogenannte «Intent Matching» statt, in welchem der Input entweder regelbasiert oder mittels Methoden des maschinellen Lernens analysiert wird.61 Beim Intent Matching geht es darum, dass der Chatbot die passenden Informationen aus den hinterlegten Daten abrufen kann.62 Bei einem regelbasierten Intent Matching erfolgt diese Zuordnung namentlich mittels Keywords63, während beim Intent Machting mittels KI eine Musterkennung verwendet wird, welche den aktuellen Input mit bestehenden Input-Output-Paaren vergleicht und die beste Lösung auswählt.64 Der letzte Schritt besteht nun darin, dass die gefundenen Informationen mit Hilfe von NLP wieder in menschliche Sprache umgewandelt und dem Nutzer die Antwort präsentiert werden kann.65 Das Ziel bei der Entwicklung eines Chatbots mit KI besteht schlussendlich darin, dass sich dieser adaptiv an die Veränderungen der Umwelt anpassen kann66, wobei auch bei dieser Kategorie von Chatbots zur gegenwärtigen Zeit eine enge Eingrenzung des rechtlichen Themenfelds nötig ist, damit brauchbare Ergebnisse bzw. Antworten entstehen können.67

3.3.

Typ 3: Die Zukunftsvision eines autonom handelnden Chatbots (starke KI) ^

In der Zukunft wäre es denkbar, dass ein Chatbot entwickelt wird, welcher über ein hohes Mass an Autonomie verfügt. Folgt man der Argumentation aus Kap. 2 und Kap. 3.2, würde dies bedeuten, dass ein solcher Chatbot zuerst für einen begrenzten Einsatzbereich entwickelt wird und sich dieser in der Folge mittels Machine- oder Deeplearning selbständig weiterentwickelt. Es wäre denkbar, dass er hierzu eigenständig auf eine grosse Menge von Daten zugreifen und dadurch Kenntnisse in anderen Rechtsgebieten erlangen kann. Die Forschung ist sich jedoch zum gegenwärtigen Zeitpunkt nicht sicher, ob ein solches System überhaupt realisierbar ist.68

3.4.

Chatbot-Matrix ^

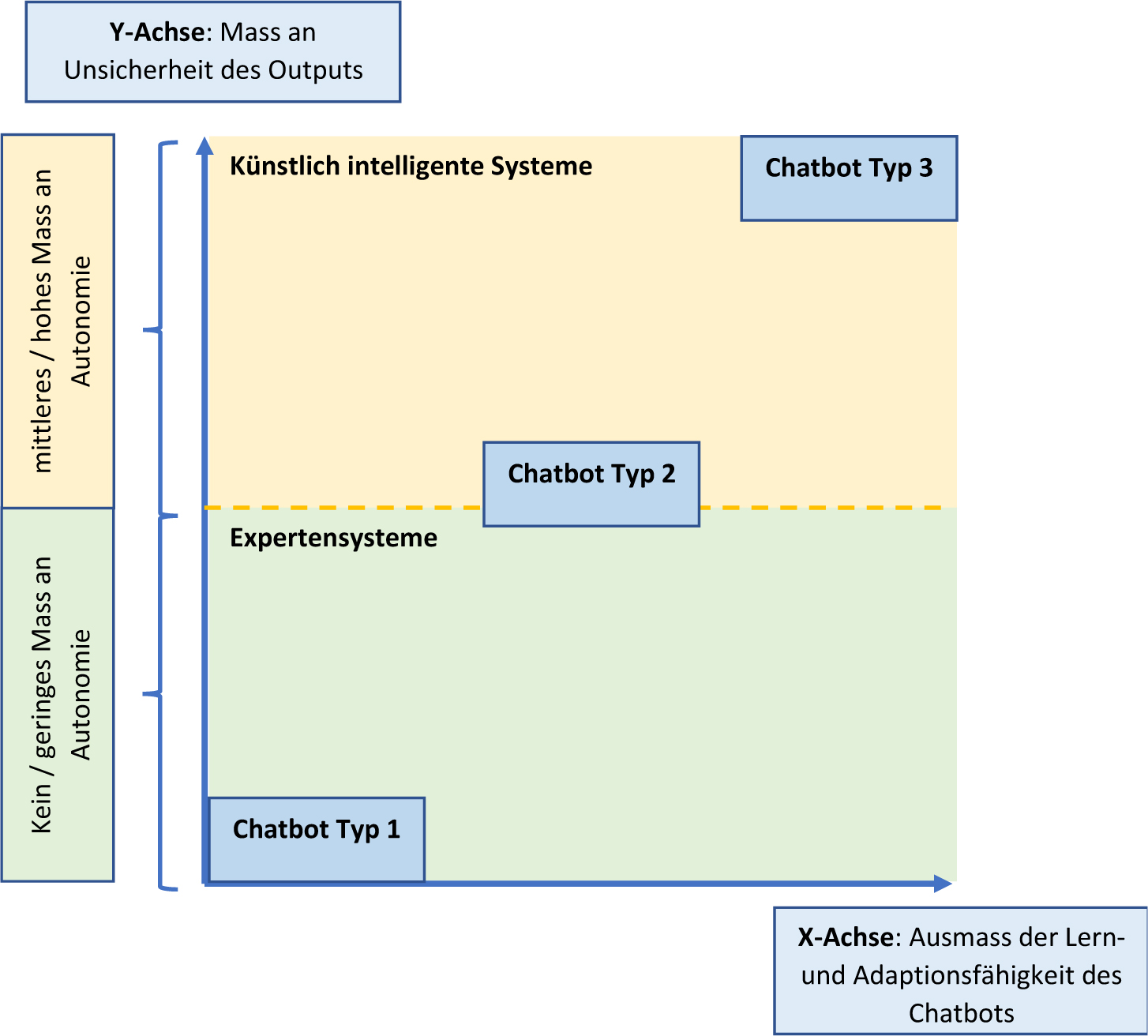

Die nachfolgende Matrix unterteilt die drei Typen der Chatbots nach dem Unterscheidungskriterium «Mass an Unsicherheit des Outputs» (unter Angabe der Autonomie des Chatbots) und der «Adaptions- und Lernfähigkeit».

Abbildung 1: Unterteilung der Chatbots nach dem «Mass an Unsicherheit des Outputs» (unter Einbezug der Autonomie), sowie der «Lern- und Adaptionsfähigkeit». Eigene Darstellung in Anlehnung an Abele/D’Onofrio, S. 36, sowie Kap. 2, 3.1, 3.2 und 3.3.

4.1.

Schäden, welche durch eine fehlerhafte Beratung durch einen Chatbot entstehen können. ^

Durch eine Rechtsberatung mittels Chatbot könnten in der Praxis diverse Schäden entstehen. In der juristischen Lehre wird bei den Schäden zwischen der Verletzung absolut geschützter Rechtsgüter und den reinen Vermögensschäden unterschieden.69 Die Verletzung absolut geschützter Rechtsgüter, welche in Personenschäden (etwa eine Körperverletzung) und Sachschäden (etwa Zerstörung eines Objekts im Eigentum des Geschädigten) unterteilt werden70, dürften im Umgang mit einem Chatbot weniger relevant sein.71 Die zweite Kategorie, der reine Vermögensschaden72, ist im hier betrachteten Gebiet hoch relevant. Als Beispiel könnte hier der Fall genannt werden, dass ein Chatbot einem Klienten eine falsche Rechtsauskunft erteilt und dieser basierend auf diesem Rat eine für ihn nachteilige Vermögensdisposition tätigt. Ebenfalls denkbar wäre, dass der Bot dem Nutzer eine falsche Frist zur Ergreifung eines Rechtsmittels oder eine falsche Verjährungsfrist mitteilt und der Klient infolgedessen einen Entscheid (namentlich über Steuern, Gebühren oder Bussen) nicht mehr anfechten kann.

4.2.

Die zugrundeliegenden (ausser-)vertraglichen Bindungen der beteiligten Parteien ^

Nach einer sorgfältigen Konsultation zahlreicher allgemeiner Geschäftsbedingungen (AGB) von unterschiedlichen Chatbot-Anbietern fällt auf, dass diese Vertragsbedingungen häufig ähnlich ausgestaltet sind. Es finden sich namentlich Bestimmungen wie «der Content auf der Website stellen keine Rechtsberatung an den Client dar, sondern dürfen ausschliesslich als unverbindliche Auskunft verstanden werden».73 Ähnliche Bestimmungen finden sich auch bei einem amerikanischen Anbieter, welcher seine Dienstleistung ausdrücklich nicht als rechtliche Beratung klassifiziert.74 Ausserdem wird häufig die Haftung beschränkt. Diese Umstände führen zur Frage, ob überhaupt ein vertragliches Verhältnis vorliegt, oder ob zur Durchsetzung von Haftungsansprüchen auf Institute der ausservertraglichen Haftung zurückgegriffen werden muss. So führt das Erteilen von Rat und Auskunft im Alltag zu diversen rechtlichen Fragen. Sofern die Auskunft im Rahmen einer «vorbestandenen, vertraglichen Beziehung» erteilt wird, stützen sich die möglichen Ansprüche auf diesen Vertrag.75 Dabei gestaltet sich die Unterscheidung, ob ein unentgeltlicher Auftrag vorhanden ist, oder eben kein vertragliches Verhältnis besteht, häufig als schwierig.76 Für diese Unterscheidung ist es massgeblich, ob es für den «Auskunftsgeber erkennbar war, dass die Antwort für den Fragenden von besonderer Bedeutung war».77 Gemäss dem Bundesgericht darf jedoch nur mit Zurückhaltung von einem Vertragsverhältnis ausgegangen werden.78 Sofern kein vertragliches Verhältnis angenommen wird, kann u.U. eine ausservertragliche Haftung nach Art. 41 OR, Art. 55 OR oder eine Vertrauenshaftung geprüft werden. Bei der ausservertraglichen Haftung nach Art. 41 OR und Art. 55 OR muss ein widerrechtliches Verhalten vorliegen.79 Bei einem reinen Vermögensschaden wird hier eine Schutznormverletzung verlangt.80 Eine solche Schutznorm kann sich aus dem geschriebenen bzw. ungeschriebenen Recht ergeben, oder aus allgemeinen Rechtsgrundsätzen abgeleitet werden.81 In Ausnahmefällen zieht das Bundesgericht hier Art. 2 ZGB als Schutznorm hinzu.82 Bei der Vertrauenshaftung liegt zwischen den Parteien eine rechtliche Sonderverbindung vor83, welche schematisch zwischen «Delikt und Vertrag»84 angesiedelt ist. Damit eine solche Haftung bejaht werden kann, muss der Schädiger beim Geschädigten durch sein Verhalten ein Vertrauen aufbauen und im Anschluss dieses Vertrauen treuwidrig enttäuschen.85 Dieser Vertrauensbruch muss adäquat kausal mit dem Schaden in Zusammenhang stehen.86 Dies wäre etwa denkbar, wenn eine Anwaltskanzlei einen Chatbot anbietet und der Klient nicht erkennen konnte, dass er nicht mit einem Menschen (Anwalt) kommuniziert. In der Praxis sind je nach Einzelfall alle Haftungsansprüche denkbar. Im nachfolgenden Abschnitt wird exemplarisch davon ausgegangen, dass zwischen dem Klienten und dem Chatbot-Anbieter (etwa einem Anwalt) ein Auftrag i.S.v. Art. 394 ff. OR vorliegt. Der Chatbot-Anbieter entwickelt die Software selbst und lässt (sofern benötigt) die künstliche Intelligenz von einem Dritten liefern. Zwischen dem Chatbot Anbieter und dem Lieferanten der KI könnte namentlich ein Lizenzvertrag oder ein Innominatvertrag bestehen.87 Ebenso wird angenommen, dass der Chatbot-Anbieter das Training der KI selbst übernimmt.

5.1.

Beschreibung der Haftungssphären ^

In diesem Bereich stellen sich keine grundlegend neuen haftungsrechtlichen Fragen88, insb. weil das System regelbasiert funktioniert und der Output einer Applikation vorhersehbar ist. Aus Sicht des Klienten erscheint es ratsam, dass er den Chatverlauf mit dem Chatbot speichert, damit er im Verfahren die fehlerhafte Auskunft des Chatbot nachweisen kann.89 Nachfolgend wird der Auftrag im Kontext der Auskunftserteilung mittels Chatbot hinsichtlich des Umfangs und der Haupt- und Nebenpflichten des Auftragnehmers analysiert:

5.2.

Umfang des Auftrages ^

Der Umfang des Auftrags bestimmt sich gemäss Art. 396 Abs 1 OR nach der Vereinbarung zwischen dem Auftraggeber und dem Auftragnehmer. Sofern sich die Vereinbarung der Parteien hinsichtlich des genauen Umfangs des Auftrages nicht äussert, bestimmt sich dieser gemäss Art. 396 Abs. 1 OR nach der Natur des zu besorgenden Geschäfts.90 In casu bestimmt sich der Umfang des Auftrages nach dem Tätigkeitsbereich des Chatbots.91

5.3.

Relevante Haupt- und Nebenpflichten des Auftragnehmers ^

Gemäss Art. 394 Abs. 1 OR verpflichtet sich der Beauftragte bei Annahme eines Auftrages, die ihm übertragenen Geschäfte oder Dienste vertragsgemäss zu besorgen. Der Beauftragte schuldet lediglich «Tätigwerden im Hinblick auf das angestrebte Ziel, nicht aber die Verwirklichung dieses Ziels».92 «Der Beauftragte haftet somit für die getreue und sorgfältige Ausführung des Auftrages».93 Ausserdem hat der Beauftragte diverse Nebenpflichten einzuhalten. Zu den typischen Nebenpflichten zählt eine Treuepflicht (gemäss Art. 398 Abs. 2 OR), welche gemäss der herrschenden Lehre namentlich einer Diskretions- oder Geheimhaltungspflicht94, eine Aufklärungs- und Benachrichtigungspflicht95, oder auch eine Rechenschafts- und Herausgabepflicht96 umfasst. Abschliessend ist die Sorgfaltspflicht als wichtige Nebenpflicht zu nennen.97

5.4.

Prüfung der Haftung Chatbot-Anbieters gegenüber dem Klienten nach dem Auftragsrecht ^

Nun erfolgt die konkrete Prüfung98 der Haftung des Anbieters eines Chatbots, sofern der Chatbot eine fehlerhafte Beratungsleistung erbringt und der Klient dadurch einen vermögensmässigen Schaden erleidet. Eine «Spät- oder Nichterfüllung» liegt dann vor, wenn der Beauftragte entweder gar nicht, zu spät oder nicht im vertraglich bestimmten Umfang tätig wird.99 Dieser Fall kann hier vermutlich gar nicht eintreten, weil sich der Umfang des Vertrages nach dem Tätigkeitsbereich des Chatbots bestimmt und der Chatbot die Anfragen in Echtzeit automatisiert beantworten kann. Daher wird nachfolgend nur die sogenannte Schlechtleistung (positive Vertragsverletzung)100 geprüft. Damit der Auftragnehmer auf Grundlage von Art. 398 Abs. 2 OR i.V.m. Art. 97 ff. OR haftbar gemacht werden kann, bedarf es einer Sorgfaltspflichtverletzung, welche kausal zu einem Schaden geführt hat.101 Nachfolgend ist eine Prüfung von Art. 97 Abs. 1 OR gemäss folgender Schritte vorzunehmen:

5.4.1.

Der Auftragsnehmer hat eine vertragliche Pflicht verletzt ^

Wie bereits erwähnt schuldet der Auftragnehmer keinen Erfolg, sondern ein sorgfältiges Tätigwerden. Die Vertragsverletzung besteht demnach in der Verletzung der Sorgfaltspflicht. Die Bestimmung des Sorgfaltsmassstabes erfolgt nach objektiven Kriterien.102 Die Lehre spricht hier von der Sorgfaltspflicht als aufsichtsrechtliches Tätigkeitsgebot.103 Der Auftragnehmer hat diejenige Sorgfalt anzuwenden, welcher «ein gewissenhafter und ausreichend sachkundiger Beauftragter aufzuwenden pflegt».104 Der Beauftragte hat sich an die Regeln der Berufskunst zu halten (sog. bereichs-/berufsspezifischer Sorgfaltsmassstab).105 Der Auftragnehmer hat das Berufsrisiko zu tragen und kann sich gerade nicht darauf berufen, dass bei «dieser Art von Tätigkeit gewisse Fehler unvermeidlich sind».106 Ferner hat der Beauftragte die Besorgung des Geschäfts abzulehnen, wenn er der gefragten Materie nicht gewachsen ist, weil er sonst ein Übernahmeverschulden zu tragen hat.107 Im hier beschrieben Fall vermögen diese Kriterien jedoch nur in einem begrenzten Umfang eine Konkretisierung des Sorgfaltsmassstabes zu bewirken.108 Namentlich der Sorgfaltsmassstab des «gewissenhaft und sachkundigen Beauftragten» hat sich im hier betrachteten Fall mangels Präzedenz noch nicht genügend konkretisiert. Nach der hier vertretenen Ansicht betrifft das Betreiben eines Chatbots zur Erteilung einer rechtlichen Auskunft gar zwei Sorgfaltspflichtssphären. Einerseits besteht die rechtliche Sphäre, in welcher der Anbieter dafür zu sorgen hat, dass die erteilte Auskunft aus rechtlicher Sicht seine Richtigkeit hat.109 Namentlich hat der Betreiber im Umfang der Auskunftssphäre des Chatbots dafür zu sorgen, dass der Klient im Rahmen einer Auskunftserteilung einen vollständigen Überblick über die zu beantwortende Rechtsfrage erhält. Dies wäre namentlich nicht der Fall, wenn relevante Aspekte der rechtlichen Beurteilung weggelassen werden. Andererseits besteht auch eine Sorgfaltspflicht in der technischen Sphäre. Der Anbieter hat zahlreiche organisatorische Massnahmen vorzunehmen, welche die Risiken eines Schadens verringern.110 Der Betreiber hat bereits bei der Erstellung des Chatbots ein Qualitätssicherungsverfahren zu erstellen, welches ein effizientes Test- und Abnahmeverfahren gewährleistet.111 Nachdem der Chatbot in Betrieb genommen worden ist, hat der Betreiber eine kontinuierliche Produktbeobachtung aufrechtzuerhalten, indem er beispielsweise eingehende Fehlermeldungen analysiert.112 In der Praxis wird es dem Betreiber vermutlich nicht zumutbar sein, dass er jede eingegangene Anfrage einzeln auf deren Richtigkeit überprüft. Er sollte jedoch nachweisen können, dass er die sektorspezifischen Standards der Technologiebranche einhält. Zu diesem Zweck sind die durchgeführten Kontrollmassnahmen genau zu dokumentieren,113 dies insbesondere, weil der Betreiber die Beweislast trägt.114 Zudem ist im Rahmen der Prüfung einer allfälligen Sorgfaltspflichtverletzung eine Abgrenzung vorzunehmen: Sofern der Schaden auf eine fehlerhafte Auskunftserteilung des Klienten zurückzuführen ist, hat sich der Chatbot-Anbieter vermutungsweise keiner Sorgfaltspflichtverletzung schuldig gemacht. Der Betreiber hat den Klienten jedoch über die sachgerechte Verwendung des Chatbots zu informieren.115

5.4.2.

Es muss ein Schaden nachgewiesen werden können ^

Der Schaden wird mit der Differenzentheorie ermittelt116. Er wird bestimmt, indem «der Stand des Vermögens des Geschädigten nach dem schädigenden Ereignis» mit dem (hypothetischen) Stand des Vermögens ohne das Ereignis verglichen wird.117 Dabei kann es sich einerseits um einen positiven Schaden handeln (damnum emergens), welcher in direkter Weise die Aktiven des Klienten vermindert oder dessen Passiven vermehrt.118 Andererseits kann der Schaden auch in Form eines entgangenen Gewinns (lucrum cessans) bestehen.119 Die Beweislast für den Nachweis des Schadens trägt der Klient, welcher seinen erlittenen Schaden mit überwiegender Wahrscheinlichkeit nachzuweisen hat.120 Der Klient kann das positive Vertragsinteresse verlangen, wonach er so zu stellen ist, wie wenn der Auftrag richtig erfüllt worden wäre.121 Sofern es für ihn vorteilhafter ist. kann er sich auch auf das negative Vertragsinteresse berufen, welches ihn so stellt, als wäre der Vertrag niemals geschlossen worden.122

5.4.3.

Adäquater Kausalzusammenhang zwischen der Vertragsverletzung und dem Schaden ^

Die Vertragsverletzung muss mit dem Schaden in einer adäquat kausalen Beziehung stehen. Gemäss dem Bundesgericht gilt «ein Ereignis […] als adäquate Ursache eines Erfolges, wenn es nach dem gewöhnlichen Lauf der Dinge und nach der allgemeinen Lebenserfahrung an sich geeignet ist, einen Erfolg von der Art des eingetretenen herbeizuführen, der Eintritt des Erfolges also durch das Ereignis allgemein als begünstigt erscheint».123 Aufgrund der Vielzahl von unterschiedlichen Schäden, welche durch eine fehlerhafte Beratung eines Chatbots entstehen können, kann hier die Adäquanz nicht allgemein bejaht werden. Massgeblich sind die Umstände des konkreten Einzelfalls. Generell kann lediglich gesagt werden, dass eine fehlerhafte Auskunft den Klienten durchaus in adäquat kausaler Weise dazu motivieren könnte, eine für ihn nachteilige Vermögensdisposition vorzunehmen.

5.4.4.

Der Auftragnehmer hat die Vertragsverletzung verschuldet ^

Bei der Analyse des Verschuldens spricht die Lehre häufig auch von der Sorgfaltspflicht als Verhaltensmaxime.124 Das Verhalten des Beauftragten darf «objektiv betrachtet (i.S. des Massstabes eines Durchschnittsbürgers) nicht als fahrlässig erscheinen; es darf nicht vorwerfbar sein».125 In der Lehre herrscht jedoch Uneinigkeit hinsichtlich des Fahrlässigkeitsbegriffs. Während ein Teil der Lehre die Fahrlässigkeit an einem objektiven Massstab bemisst126, spricht sich der andere Teil der Lehre für eine gewisse «Re-Subjektivierung» des «Verschuldens» aus.127 Wird der letzteren Ansicht der Vorzug gegeben, dann kann es ausnahmsweise vorkommen, dass der «Beauftragte zwar objektiv eine Pflicht verletzt […] ihm dies jedoch mangels tauglicher Handlungsalternativen subjektiv nicht vorgeworfen werden» kann und daher «die Bejahung des Verschuldens mithin als unbillig» erscheint (vgl. Art. 4 ZGB).128 Sofern ein objektivierter Verschuldensbegriff zur Anwendung gelangt, dürfte die Exkulpation bei einer Sorgfaltspflichtverletzung faktisch nicht möglich sein.129 Verschulden bezeichnet den Umstand, dass der Auftragnehmer den Auftraggeber in pflichtwidriger Weise schädigt, obwohl ersterer in der Lage gewesen wäre, den Schaden vorauszusehen und abzuwenden. Dies bedeutet, dass die Schadensverursachung für den Beauftragten zumindest erkennbar gewesen sein muss.130 Das Verschulden kann in einer vorsätzlichen oder fahrlässigen Pflichtverletzung geschehen.131 Der Beauftragte handelt vorsätzlich, wenn er einen bestimmten Erfolg mit Wissen und Willen herbeiführt.132 Bei der Fahrlässigkeit wird zwischen einer schweren, mittleren und leichten Fahrlässigkeit unterschieden. Eine schwere Fahrlässigkeit liegt vor, wenn der Auftragnehmer «elementare Vorsichtsgebote ausser Acht lässt, die jeder verständige Mensch in der gleichen Lage und unter den gleichen Umständen befolgt hätte», wobei das Handeln des Schädigers schlicht als unverständlich erscheint.133 Die mittlere Fahrlässigkeit liegt vor, wenn der Auftragnehmer «den Durchschnittsanforderungen nicht gerecht wird».134 Die leichte Fahrlässigkeit stellt «eine geringe Abweichung von der erforderlichen Sorgfalt» dar, welche jedem passieren kann.135 In der Praxis dürfte, sofern eine Sorgfaltspflichtverletzung vorliegt, häufig auch ein Verschulden festzustellen sein. Ausserdem wird gemäss Art. 97 Abs. 1 OR ein Verschulden vermutet, was eine Beweislastumkehr bedeutet.

5.4.5.

Zwischenfazit ^

Unter der Annahme, dass zwischen dem Chatbot-Betreiber und dem Klienten ein Auftrag besteht, kann davon ausgegangen werden, dass die Haftung des Betreibers zumindest möglich erscheint. Die Bewertung wird im hier beschrieben Fall vor allem dadurch erschwert, dass der zugrundeliegende Sorgfaltsmassstab mangels Präzedenz nicht hinreichend konkretisiert ist.

5.4.6.

Prüfung einer möglichen Haftungsbeschränkung ^

Gemäss Art. 97 i.V.m Art. 99 Abs. 1 OR haftet der Schuldner (in casu der Chatbot-Betreiber) für jedes Verschulden. Hierbei handelt es sich jedoch um eine dispositive Regelung, welche namentlich durch die Abgabe von AGB eingeschränkt werden kann.136 Einerseits besteht die Möglichkeit, die Haftung für leichtes Verschulden auszuschliessen.137 Bei dieser Art der Haftungsbeschränkung ist zu beachten, dass sie bei vorsätzlichem oder grob fahrlässigem Verhalten keine Anwendung finden kann.138 Andererseits kann die Haftung beschränkt werden, indem «die Folgen der Vertragsverletzung begrenzt oder ausgeschlossen werden».139 Eine dritte, indirekte Möglichkeit der Haftungsfreizeichnung würde darin bestehen, dass die Pflichten des Auftragnehmers im zugrundeliegenden Vertrag besonders eng umschrieben werden.140 Diese Form erscheint hier nicht relevant, weil sich der Umfang des Auftrages nach dem hier geprüften Beispiel direkt aus dem Tätigkeitsbereich des Chatbots ableiten. Damit die AGB im Vertrag Geltung erlangen, müssen sie in das zugrundeliegende Vertragswerk einbezogen werden (sog. Einbezugskontrolle).141 Dies bedeutet im Umkehrschluss, dass diese Information vermutlich durch den Chatbot direkt herausgegeben werden müssen, oder dass der Chatbot zumindest auf die vertraglichen Bestimmungen verweist. Ferner ist zu prüfen, ob die Parteien nicht eine anderslautende Individualvereinbarung getroffen haben (Geltungskontrolle).142 Eine Vertragsklausel der AGB kommt im Zweifelsfall nicht zur Anwendung, wenn der Vertragspartner vernünftigerweise nicht mit einer solchen Klausel rechnen musste (Ungewöhnlichkeitsregel im Rahmen der Geltungskontrolle).143 Der Klient muss zudem die Tragweite der Haftungsfreizeichnung erfassen können.144 Ausserdem wird eine unklar formulierte AGB-Klausel im Zweifelsfall zuungunsten des Verfassers ausgelegt (Unklarheitenregel im Rahmen der Auslegungskontrolle).145 Nach der konstanten Rechtsprechung des Bundesgerichts hat ein Gericht jedoch keine Möglichkeit, die AGB inhaltlich zu prüfen (offene Inhaltskontrolle),146 dies obwohl die herrschende Lehre seit längerer Zeit eine offene Inhaltskontrolle entlang von Art. 19 und Art. 20 Abs. 1 OR (öffentliche Ordnung und Sittenwidrigkeit) fordert.147 Eine Inhaltskontrolle ist ausnahmsweise möglich, wenn der Anwendungsbereich von Art. 8 UWG eröffnet ist, d.h. die AGB im Rahmen eines Konsumentenvertrages148 ein ungerechtfertigtes und erhebliches Missverhältnis bewirken.149

Abschliessend ist noch eine wichtige Differenzierung vorzunehmen. Wie bereits festgestellt, erlaubt das Gesetz eine Beschränkung der Haftung im Bereich des Verschuldens. Eine Beschränkung des Sorgfaltsmassstabs ist nur insofern möglich, als dass hier die Risiken beschränkt werden können, welche durch den Auftragnehmer nicht beeinflussbar sind.150 Nicht möglich ist eine Beschränkung der «berufs- oder sachspezifischen Sorgfalt».151 Insofern ist eine Haftungsbeschränkung zwar möglich, wobei es fraglich erscheint, ob sich der Chatbot-Anbieter mittels solcher Klauseln exkulpieren kann. Es müsste vermutlich mit einem hohen Sorgfaltsmassstab gerechnet werden, sofern zwischen dem Chatbot-Betreiber und dem Klienten tatsächlich ein Auftragsverhältnis bejaht wird. Erschwerend kommt hinzu, dass der Nachweis eines nur leichten oder mittelschweren Verschuldens in der Praxis wohl nicht leicht erbracht werden kann.

6.

Haftungsrechtliche Beurteilung eines Chatbots Typ 2 ^

Grundsätzlich muss erwähnt werden, dass die hier gestellte Frage der Haftung für den Chatbot Typ 2 nicht abschliessend beurteilt werden kann, weil es in diesem Bereich in doppelter Hinsicht an Präzedenz mangelt. Einerseits hat sich noch kein Gericht mit der Frage befassen müssen, wer die Haftung zu tragen hat, wenn ein Chatbot eine falsche rechtliche Beurteilung abgibt.152 Andererseits existieren, soweit ersichtlich, noch keine gerichtlichen Entscheide zu Schäden, welche durch autonome Systeme verursacht wurden.153 Eine besondere Problematik besteht insbesondere dann, wenn der Schaden auf die eigendynamische Weiterentwicklung des Systems zurückzuführen ist.154 Diese Konstellation von Schäden führt zu zwei Unsicherheitsbereichen: Einerseits zeichnen sich KI-Anwendungen durch eine Komplexität aus155, welche die Identifikation der Fehlerquelle erschwert oder gar verunmöglicht.156 Denkbar wäre, dass die KI an sich fehlerbehaftet ist, namentlich weil sie die vertraglich versprochenen Leistungen gar nicht zu erbringen vermag. Ferner könnte dem Betreiber beim Training der KI fehlerhafte Daten verwendet haben. Zudem wäre es möglich, dass sich die KI in einer unvorhersehbaren Weise weiterentwickelt und darauf basierend ein Schaden entsteht. Die zweite Problematik besteht in der Zuordnung der Handlungen der KI an sich. Ein KI-System kann selbst nicht haftbar gemacht werden, da es über keine Rechtspersönlichkeit verfügt.157 Damit die Rechtspersönlichkeit bejaht werden könnte, bedarf es der Rechtsfähigkeit gemäss Art. 11 ZGB, welche einer KI bis zum gegenwärtigen Zeitpunkte nicht zugesprochen wurde.158 Dies bedeutet im hier betrachteten Fall im Umkehrschluss, dass eine Zurechnungsnorm benötigt werden würde, welche die schädigende Handlung der KI dem Chatbot-Betreiber zurechnet. Nachfolgend werden einige Vorschläge von möglichen Zurechnungsnormen aufgegriffen.159 In der Lehre wird zur Zeit kontrovers diskutiert, ob eine KI unter die Hilfspersonenhaftung gemäss Art. 101 OR, resp. Geschäftsherrenhaftung nach Art. 55 OR subsumiert werden könnte.160 Eine direkte Anwendung von Art. 101 OR auf künstlich intelligente Systeme würde jedoch von der herrschenden Lehre vermutlich abgelehnt werden, insbesondere weil unter den Begriff der Hilfsperson nur eine natürliche oder juristische rechtsfähige Person zu subsumieren ist.161 Es gibt jedoch Lehrmeinungen, welche die analoge Anwendung von Art. 101 OR auf KI erlauben möchten,162 während andere Autoren einen solchen Analogieschluss eher ablehnen.163 Die analoge Anwendung von Art. 101 OR erscheint nach der hier vertretenen Ansicht eine sachgerechte Lösung darzustellen.164 Es leuchtet ein, dass ein Geschäftsherr, welcher seinen Tätigkeitsbereich durch Beizug einer KI erweitert, auch die dazu gehörigen Risiken tragen soll.165 Es wäre vermutlich wenig überzeugend, den Geschäftsherrn für den Schaden verantwortlich zu machen, welcher durch einen hinzugezogenen menschlichen Gehilfen entsteht, gleichzeitig aber von einer Haftungszurechnung abzusehen, wenn er einen digitalen Gehilfen einsetzt.166 Gleichzeitig könnten die durch die KI verursachten Risiken dadurch abgemildert werden, indem der Geschäftsherr ein erhöhtes Mass an Sorgfalt zu tragen hat.167 Ein Teil der Lehre spricht sich auch für die Schaffung einer Gefährdungshaftung aus.168 Bei einer Gefährdungshaftung handelt es sich um eine spezielle Form der Kausalhaftung, welche sich alleine im Bestehen einer Gefahr begründet und kein Verschulden voraussetzt.169 Dabei herrscht in der Lehre Uneinigkeit, ob eine KI überhaupt über die benötigte Gefahrenintensität und ein erforderliches inhärentes Schadenspotential verfügt.170 Nach der hier vertretenen Ansicht wäre dies u.U. eine Lösung, wobei zurzeit das Schweizer Recht noch keine allgemeine Gefährdungshaftung kennt.171 Dies erscheint insofern problematisch, als dass ein Schaden durch eine KI bereits zum gegebenen Zeitpunkt auftreten könnte, wenngleich eine geeignete Haftungsnorm dieser Art im Moment nicht aufrufbar wäre. Daher eignet sich dieser Lösungsansatz bei gegenwärtig auftretenden Schäden nicht zur Problemlösung.

6.1.

Prüfung der Haftung Chatbot-Anbieters gegenüber dem Klienten nach dem Auftragsrecht ^

Sofern die Haftungszuordnung nach Art. 101 Abs. 1 OR erfolgen kann, wäre eine parallele Anwendung des Prüfschemas aus Kap. 5.4 denkbar. Es sind jedoch gewisse Ergänzungen nötig, auf welche nachfolgend eingegangen wird.

6.1.1.

Vertragsverletzung und Verschulden ^

Die in Kap. 5.4.1 getätigte Aussagen haben auch hier Geltung, werden jedoch um Sorgfaltspflichten im Bereich des Umgangs mit der KI erweitert. Hierzu könnten die im Haftpflichtrecht geltenden drei Curare als Massstab herangezogen werden, wonach den Betreiber hinsichtlich der KI eine cura in eligendo (Sorgfalt in der Auswahl), eine cura in instruendo (Sorgfalt im Instruieren) und einer cura in custodiendo (Sorgfalt bei der Überwachung) zu wahren hat.172 Mangels Präzedenz fällt es schwer, die hier genannten Pflichten weiter zu konkretisieren. Unter die Sorgfaltspflicht der Auswahl könnte namentlich die Pflicht subsumiert werden, eine geeignete KI als Grundlage für die Applikation zu wählen. Im Rahmen der Sorgfaltspflicht im Instruieren hat der Anbieter der KI genügend Testfälle zur Verfügung zu stellen, sodass eine hinreichend grosse Genauigkeit173 der Ergebnisse erreicht werden kann. Die Sorgfaltspflicht der Überwachung könnte namentlich darin bestehen, dass der Anbieter regelmässig Stichproben des Outputs vorzunehmen hat. Der Betreiber hat diese Tätigkeiten genau zu dokumentieren, und trägt im Schadensfall die Beweislast (vgl. Art. 97 Abs. 1 OR). Ein Verschulden besteht gemäss den Ausführungen aus Kap. 5.4.4 nur dann, wenn der Schaden für den Auftragnehmer voraussehbar war und er diesen hätte abwenden können. Dies bedeutet im Umkehrschluss, dass er vermutlich für Fehler in der automatisierten Beratung nicht haftbar gemacht werden kann, sofern er die nötige Sorgfaltspflicht eingehalten hat und die Gefahr einer Schädigung für ihn nicht erkennbar war.

6.1.2.

Schaden und Adäquater Kausalzusammenhang ^

Hier wird auf die Ausführungen in Kap. 5.4.2 und 5.4.3 verwiesen.

6.1.3.

Prüfung einer möglichen Haftungsbeschränkung ^

Auch an dieser Stelle wird auf die Ausführungen von Kap. 5.4.6 verweisen. Zusätzlich muss jedoch die Frage gestellt werden, ob die Haftung der Hilfsperson (in casu der KI) i.S.v. Art. 101 Abs. 2 OR in diesem Fall gänzlich hinwegbedingt werden kann.174 Hier wird die Ansicht vertreten, dass dies vermutlich nicht möglich ist, weil die KI zugleich die Sorgfaltspflicht des Auftragnehmers beschlägt und in der Folge eine Haftungsbeschränkung des durch die KI verursachten Schadens nur für leichtes und mittleres Verschulden des Geschäftsherrn (analog von Art. 100 Abs. 1 OR) möglich sein dürfte.175

6.2.

Die Möglichkeit eines Rückgriffs auf den Hersteller der KI ^

Diese Frage lässt sich vermutlich nicht in allgemeiner Weise beantworten. Insbesondere weil zwischen dem KI-Anbieter und dem Chatbot-Anbieter sehr unterschiedliche Verträge denkbar sind.176 Zentral sind hier die zugrundeliegenden vertraglichen Vereinbarungen.177 In der Praxis werden die KI-Anbieter jedoch weitreichende Haftungsbeschränkungen geltend machen. Ferner ist die genaue Funktionsweise einer KI teilweise gänzlich unbekannt,178 was den Nachweis eines systematischen Fehlers in der KI noch einmal zusätzlich erschwert.

7.

Haftungsrechtliche Beurteilung eines Chatbots Typ 3: Eine Frage der Zukunft ^

Wie bereits in Kap. 6 erwähnt, vermögen die vorhandenen haftungsrechtlichen Bestimmungen nach der hier vertretenen Ansicht die Fragen bis und mit einem Chatbot Typ 2 zu beantworten. Bei zunehmendem Fortschritt der künstlichen Intelligenz stellt sich jedoch ab einem gewissen Grade die Frage, ob die KI überhaupt noch unter die Hilfsperson i.S.v. Art. 101 Abs.1 OR zu subsumieren ist. Nebst einer Gefährdungshaftung, welche bereits in Kap. 6 besprochen wurde, schlägt ein Teil der Lehre die Schaffung einer sogenannten E-Person vor, welche mit einer Haftpflichtversicherung auszustatten wäre.179 Auch hier herrscht Uneinigkeit in der Lehre. Gegner machten u.a. geltend, dass eine solche Lösung zu Fehlanreizen führen könnte, da dem Betreiber das Interesse daran fehle, die KI und ihre Ergebnisse zu kontrollieren und er weniger Massnahmen zu Schadensminimierung vornehmen würde.180 Ausserdem bestehe laut Scheufen ein falsches Verständnis einer KI, wenn man dieser eine rechtliche Persönlichkeit zuordnen möchte.181 Gemäss seiner Ansicht entstehen die Schäden nicht durch ein vorsätzliches oder fahrlässiges Verhalten einer absolut autonom handelnden KI, sondern lassen vielmehr eine menschliche Fehlleistung, namentlich die Auswahl schlechter Daten oder einer ungeeigneten Zielfunktion, erkennen.182 Befürworter argumentieren, dass der Staat durch die Schaffung einer E-Person verbesserte Steuerungsmöglichkeit hätte, indem er namentlich die Pflicht einer Registerführung oder einer Genehmigungspflicht einführen könnte.183 Schlussendlich kann die Frage, ob die Schaffung einer E-Person sinnvoll erscheint, zum gegenwärtigen Zeitpunkt nicht abschliessend beantwortet werden, gerade weil die künftigen Fortschritte im Bereich der Systeme mit künstlicher Intelligenz nicht präzise vorausgesagt werden können.

8.

Zusammenfassung und Fazit ^

Bei der Analyse der Fragestellung «Inwiefern bestehen für das Anbieten einer automatisierten Rechts-beratung mittels Chatbot haftungsrechtliche Risiken?» besteht insofern die Problematik, als dass die Lehre sich bis zum gegenwärtigen Zeitpunkt noch nicht mit einem Fall aus der Praxis zu beschäftigen hatte. Es fehlen gerichtliche Entscheide sowohl zur Frage, unter welchen Umständen ein Chatbot-Anbieter für seine fehlerhaften Auskünfte haftbar gemacht werden kann, als auch, wie Schäden zu bewerten sind, welche aufgrund einer eigendynamischen Entwicklung von KI-Systemen entstanden sind. Diese Arbeit unternimmt einen ersten Versuch der haftungsrechtlichen Einordnung. Dabei besteht die erste Schwierigkeit darin, dass zugrundeliegende (ausser)vertragliche Verhältnis zwischen dem Chatbot-Betreiber und dem Klienten zu identifizieren. Nach der hier vertretenen Ansicht könnte der Klient in der Praxis einen durch fehlerhafte Beratungsdienstleistungen entstandenen Schaden je nach den Umständen des Einzelfalls auf Basis einer Vertrauenshaftung, einer Deliktshaftung (nach Art. 41 ff. OR) oder des Auftragsrechts (Art. 394 ff. OR) geltend machen. Exemplarisch wurde hier die Prüfung nach Auftragsrecht durchgeführt. Im Bereich der regelbasierten Chatbots ist eine Haftung gemäss der durchgeführten Analyse zumindest denkbar. Bei diesen Systemen besteht der Vorteil, dass der Output vorhersehbar ist, wodurch sich vermutlich der hier veranschlagte strenge Massstab für die Sorgfaltspflichten rechtfertigt. Nach der hier vertretenen Ansicht beschlägt die Sorgfaltspflicht des Chatbot-Anbieters zugleich zwei Sphären, nämlich die rechtliche und technische. Für den Betreiber eines Chatbots kommt erschwerend hinzu, dass er im Rahmen einer Haftungsbeschränkung zwar die Haftung für leichtes Verschulden hinwegbedingen kann, ihm jedoch die Herabsetzung des geforderten Sorgfaltsmassstabes nicht möglich sein dürfte. Im Rahmen der künstlich intelligenten Systeme tritt ein weiterer zentraler Faktor hinzu. Es können Schäden entstehen, welche auf eine eigendynamische Entwicklung des Chatbots zurückzuführen sind. Hier besteht die Problematik, dass in der Lehre Uneinigkeit darüber besteht, welche Zurechnungsnorm für Handlungen der KI angewendet werden soll. In dieser Arbeit wird die Ansicht vertreten, dass sich im betrachteten Fall die Hilfspersonenhaftung gemäss Art. 101 OR am besten als Zurechnungsnorm eignet. Sofern die Zurechnung der Handlungen eines künstlich intelligenten Systems mittels der Hilfspersonenhaftung bejaht wird, ist hier eine Haftung des Chatbot-Betreibers ebenfalls denkbar. Schwierigkeiten bereitet auch die Festlegung des geforderten Sorgfaltsmassstab. Denkbar wäre, dass nebst den bereits erwähnten Faktoren (bei den regelbasierten Systemen) im Hinblick auf die KI drei weitere Pflichten hinzukommen könnten. Einerseits hat der Anbieter die Pflicht, eine geeignete KI auszuwählen (Cura in eligendo), diese mit genügenden Daten zu trainieren (Cura in instudiendo) und schliesslich auch währen des Betriebs eine geeignete Überwachung des Systems sicherzustellen (Cura in custodiendo). Zum Schluss wird ein Ausblick in die Zukunft gewagt. Die Lehre diskutiert im Kontext immer intelligenter werdenden Systeme auch die Frage, ob diesen eine eigene Rechtspersönlichkeit (E-Person) zugesprochen werden, oder ob Betreiber von künstlich intelligenten Systemen einer Gefährdungshaftung unterstellt werden sollen. Nach der hier vertretenen Ansicht rechtfertigen sich solche Massnahmen zum gegenwärtigen Zeitpunkt jedoch noch nicht.

Michael Krähenbühl, B.A. Student HSG in Rechtswissenschaft mit Wirtschaftswissenschaften, Universität St. Gallen.

- 1 Prior Patrick, Ersetzen Legal Tech Chatbots bald Rechtsanwälte?, abgerufen von: https://advotisement.de/legal-tech/legal-chatbot-rechtsanwalt/.

- 2 Vgl. hierzu https://www.justus-beratung.ch/.

- 3 Vgl. hierzu https://www.verein-legal-help.ch/anfrage-starten/.

- 4 Vgl. hierzu https://chatbot.it.bund.de.

- 5 Vgl. hierzu https://donotpay.com/.

- 6 Namentlich der Anbieter Advobot https://advobot.de/.

- 7 Zur Definition des Chatbots vgl. Kap. 3.

- 8 In Englisch als artificial intelligence (nachfolgend AI) bezeichnet.

- 9 In der Fachliteratur lassen sich zu den hier definierten Begriffen oft sehr unterschiedliche und teils divergierende Definitionen finden.

- 10 So etwa Martinis Ioannis, Legal Tech: Disruptive Entwicklungen im Rechtsmarkt, in: Magister Editions, hrsg. von Weblaw, Bern 2018, (zit. Martinis, Entwicklungen im Rechtsmarkt), S. 37; Abele David/D’Onofrio Sara, Artificial Intelligence – The Big Picture, in: Cognitive Computing Theorie, Technik und Praxis, S. 31–66, hrsg. von Portmann Edy/D’Onofrio Sara, Wiesbaden 2020, S. 34.

- 11 Abele/D’Onofrio (Fn. 10), S. 34.

- 12 Wanger Jens, Legal Tech und Legal Robots Der Wandel im Rechtswesen durch neue Technologien und Künstliche Intelligenz, 4. Aufl., Wiesbaden 2018, S. 63.

- 13 Weber Rolf H./Henseler Simon, Regulierung von Algorithmen in der EU und in der Schweiz, Zeitschrift für Europarecht (EuZ), 2/2020, S. 28–42, hrsg. von Europa Institut an der Universität Zürich, Institut für deutsches und europäisches Gesellschafts- und Wirtschaftsrecht an der Universität Heidelberg, Zürich 2020, S. 28.

- 14 Es handelt sich hier um ein sog. Expertensystem, vgl. hierzu Martini Mario, Blackbox Algorithmus – Grundfragen einer Regulierung Künstlicher Intelligenz, Berlin 2019, S. 19 und ferner Weber/Henseler (Fn. 13), S. 28.

- 15 Der Begriff der KI und des ML wird oft synonym verwendet, Döbel Inga et al., Maschinelles Lernen Eine Analyse zu Kompetenzen, Forschung und Anwendung, hrsg. von Fraunhofer-Allianz Big Data und Künstliche Intelligenz, München 2018 (zit. Döbel et al., Maschinelles Lernen Eine Analyse), S. 4.

- 16 Döbel Inga et al., Maschinelles Lernen – Kompetenzen, Anwendungen und Forschungsbedarf, hrsg. von Fraunhofer-Allianz Big Data und Künstliche Intelligenz, München 2018, (zit. Döbel et al., Maschinelles Lernen – Kompetenzen), S. 9.

- 17 Döbel et al., Maschinelles Lernen Eine Analyse (Fn. 15), S. 8.

- 18 Hecker Dirk et al., Zukunftsmarkt künstliche Intelligenz Potenziale und Anwendungen, hrsg. von Fraunhofer-Allianz Big Data und Künstliche Intelligenz, München 2017, S. 8.

- 19 Martinis Ioannis, Legal AI – Pilotprojekt der Coop Rechtsschutz AG mit IBM Watson. (Podcast), LegalTech, Brown Bag, hrsg. von Weblaw, abgerufen von: https://legaltech.weblaw.ch/videos/ai_coop_ibm (zit. Martinis, Legal AI), Im rechtlichen Bereich besteht insbesondere das Problem, das nicht genügend Testdaten vorhanden sind. Vgl. ferner Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 38.

- 20 Wanger (Fn. 12), S. 63.

- 21 Bei den Labels handelt es sich um die gewünschte Lösung der getätigten Eingabe, vgl. hierzu Döbel et al., Maschinelles Lernen Eine Analyse (Fn.15), S. 8.

- 22 Hecker et al. (Fn. 18), S. 10, überwachtes Lernen ist besonders wichtig, wenn der Algorithmus Werte schätzen oder Objekte klassifizieren soll; vgl. ferner Döbel et al., Maschinelles Lernen – Kompetenzen (Fn. 16), S. 25.

- 23 Diese Methode kommt v.a. bei grossen unstrukturierten Datenmengen zum Einsatz, bei denen man noch gar nicht weiss, nach welchen Kriterien sie aufgeteilt werden können; vgl. hierzu Döbel et al., Maschinelles Lernen – Kompetenzen (Fn. 16), S. 25 f.

- 24 Döbel et al., Maschinelles Lernen – Kompetenzen (Fn. 16), S. 28.

- 25 Kriesel Thomas, Stellungnahme Rechtsfragen der digitalisierten Wirtschaft: Haftung für Systeme Künstlicher Intelligenz, hrsg. von Bundesverband Informationswirtschaft, Telekommunikation und Neue Medien (bitkom), Berlin 2020, S. 9.

- 26 Klaus Samuel/Jung Claudia, Rechtliche Aspekte «Künstlicher Intelligenz» (KI), Newsletter Information und Communication Technology, 10/2019, hrsg. von Schellenberg Wittmer, Zürich 2019, Kap. 1.2.

- 27 Klaus/Jung (Fn. 26), Kap. 1.2, gemäss Döbel et al., Maschinelles Lernen – Kompetenzen (Fn. 16), S. 23 sind neuronale Netzwerke für die Fortschritte im Bereich Natural Language Processing verantwortlich, vgl. dazu Kap. 3.2.

- 28 Kriesel (Fn. 25), S. 5; eine ähnliche Definition findet sich in Vöpel Henning, Wie künstliche Intelligenz die Ordnung der Wirtschaft revolutioniert, Wirtschaftsdienst, 98. Jahrgang, Heft 11, S. 828–830, hrsg. von ZBW – Leibniz-Informationszentrum Wirtschaft, Kiel/Hamburg 2018, S. 828.

- 29 Kriesel (Fn. 25), S. 5.

- 30 Bleskie Nicolai, Künstliche Intelligenz und haftungsrechtliche Konsequenzen, Jusletter vom 24. Mai 2018, hrsg. von Wiegand Wolfgang/Montani Sarah/Kummer Franz, Bern 2018, S. 4 stellt noch weitere Anforderungen an eine schwache KI, wie namentlich «Eigenaktivität bzw. Eigenständigkeit, Kreativitäts- und Anpassungsoptionen». Eine ähnliche Sicht wird in Abele/D’Onofrio (Fn. 10), S. 37 vermittelt.

- 31 Namentlich wird hier auf Abele/D’Onofrio (Fn. 10), S. 38; sowie Kriesel (Fn. 25), S. 5 verwiesen.

- 32 Vöpel (Fn. 28), S. 828.

- 33 Abele/D’Onofrio (Fn. 10), S. 37.

- 34 Resp. Unexplainable AI, vgl. hierzu Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 44.

- 35 Döbel et al., Maschinelles Lernen – Kompetenzen (Fn. 16), S. 82.

- 36 Abele/D’Onofrio (Fn. 10), S. 56.

- 37 Döbel et al., Maschinelles Lernen – Kompetenzen (Fn. 16), S. 82.

- 38 Abele/D’Onofrio (Fn. 10), S. 56.

- 39 Kriesel (Fn. 25), S. 5.

- 40 Kriesel (Fn. 25), S. 5.

- 41 Kriesel (Fn. 25), S. 5.

- 42 Martinetz Sophie/Maringele Sarah, Quick Guide Legal Tech Schritt für Schritt zur digitalen Kanzlei und Rechtsabteilung, Wiesbaden 2020, S. 20.

- 43 Einige Autoren versehen solche Systeme auch mit dem Begriff «Legal-Robot», wie namentlich Wanger (Fn. 12), S. 55.

- 44 Hanke Philip, Legal Tech – Cognitive Computing in der juristischen Praxis, in: Cognitive Computing Theorie, Technik und Praxis, S. 207–222, hrsg. von Portmann Edy/D’Onofrio Sara, Wiesbaden 2020, S. 208, gemäss der Terminologie aus Kap. 2 handelt es sich um ein Expertensystem.

- 45 Hanke (Fn. 44), S. 212.

- 46 Hanke (Fn. 44), S. 210.

- 47 Wanger (Fn. 12), S. 58.

- 48 Diese Aussage wurde indirekt abgeleitet von Stucki Toni/D’Onofrio Sara/Portmann Edy, Chatbots gestalten mit Praxisbeispielen der Schweizerischen Post HMD Best Paper Award 2018, Wiesbaden 2020, S. 7.

- 49 Wanger (Fn. 12), S. 58 f.

- 50 Hanke (Fn. 44), S. 211.

- 51 Martinetz/Maringele (Fn. 42), S. 19, namentlich IBM bietet mit Watson eine solche NLP-KI, vgl. hierzu IBM, Watson: Natural Language Understanding, abgerufen von: https://www.ibm.com/cloud/watson-natural-language-understanding.

- 52 Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 41 f.

- 53 Vgl. hierzu IBM, Watson: Advertising Conversations, abgerufen von: https://www.ibm.com/products/watson-advertising-conversations.

- 54 Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 41 f.

- 55 Vgl. hierzu IBM, Watson: Discovery, abgerufen von: https://www.ibm.com/cloud/watson-discovery.

- 56 Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 42.

- 57 Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 42; Dieser Schritt wird als «Intent Matching» bezeichnet, vgl. hierzu Mackmood Julie/Bammert Marty Daniel/D’Onofrio Sara, Chatbot & Cognitive Services – Ein Schritt Richtung Automatisierung im User Help Desk der Schweizerischen Post, in: Cognitive Computing Theorie, Technik und Praxis, S. 147–168, hrsg. von Portmann Edy/D’Onofrio Sara, Wiesbaden 2020, S. 152.

- 58 Mackmood/Bammert Marty/D’Onofrio (Fn. 57), S. 151 ff.; Für weitere Informationen zur AI Plattform von Microsoft vgl. Microsoft, AI platform, tools and services, abgerufen von: https://www.microsoft.com/en-us/ai/ai-platform.

- 59 Vgl. hierzu https://www.post.ch/de/geschaeftsloesungen/kmu/chatbot.

- 60 Mackmood/Bammert/D’Onofrio (Fn. 57), S. 152.

- 61 Mackmood/Bammert/D’Onofrio (Fn. 57), S. 152.

- 62 Mackmood/Bammert/D’Onofrio (Fn. 57), S. 152.

- 63 Martinetz/Maringele (Fn. 42), S. 20.

- 64 Mackmood/Bammert/D’Onofrio (Fn. 57), S. 152.

- 65 Mackmood/Bammert/D’Onofrio (Fn. 57), S. 152.

- 66 Gnewuch Ulrich/Feine Jasper/Morana Stefan/Maedche Alexander, Soziotechnische Gestaltung von Chatbots, in: Cognitive Computing Theorie, Technik und Praxis, S. 169–186, hrsg. von Portmann Edy/D’Onofrio Sara, Wiesbaden 2020, S. 184.

- 67 Wanger (Fn. 12), S. 71.

- 68 Wanger (Fn. 12), S. 75, vgl. zur Frage der Realisierbarkeit Wanger (Fn. 12), S. 66 f.

- 69 Furrer Andreas/Müller-Chen Markus, Obligationenrecht Allgemeiner Teil, 3. Aufl., Zürich/Basel/Genf 2018, S. 311.

- 70 Furrer/Müller-Chen (Fn. 69), OR AT, S. 311.

- 71 Namentlich auch, weil über diese Rechte häufig in einem gerichtlichen Verfahren entschieden wird.

- 72 Bei dieser Art von Schaden braucht es bei der der aussenvertraglichen Haftung eine spezielle Schutznorm, damit die Widerrechtlichkeit einer Handlung bejaht werden kann, vgl. Kap. 4.2, sowie Furrer/Müller-Chen, OR AT (Fn. 69), S. 343.

- 73 Vgl. hierzu https://www.verein-legal-help.ch/datenschutzerklaerung/.

- 74 Vgl. hierzu https://donotpay.com/learn/terms-of-service-and-privacy-policy/.

- 75 Urwyler Thierry, «Reden ist Silber, Schweigen ist Gold» – eine Abhandlung zur Haftung für Rat und Auskunft, in: Ohne jegliche Haftung – Festschrift für Willi Fischer, S. 529–540, hrsg. von Böhme Anna/Gähwiler Fabian/Theus Simoni/Zuberbühler Ivo, Zürich 2016, S. 532.

- 76 Furrer/Müller-Chen, OR AT (Fn. 69), S. 344; Furrer Andreas/Müller-Chen Markus, Obligationenrecht Besonderer Teil, 3. Aufl., Zürich/Basel/Genf 2018, S. 271.

- 77 Furrer/Müller-Chen, OR BT (Fn. 76), S. 271.

- 78 BGE 112 II 347, vgl. ferner BGE 124 III 363, und Furrer/Müller-Chen, OR AT (Fn. 69), S. 345.

- 79 Urwyler (Fn. 75), S. 532.

- 80 Urwyler (Fn. 75), S. 534.

- 81 Urwyler (Fn. 75), S. 534.

- 82 Urwyler (Fn. 75), S. 535; Sommer Ueli Vertrauenshaftung, Anstoss zur Neukonzeption des Haftpflicht- und Obligationenrechts?, in: Aktuelle Juristische Praxis (AJP)/Pratique Juridique Actuelle (PJA), 09/2006, S. 1031–1041, hrsg. von Rusch Arnold F., Zürich 2010, S. 1033.

- 83 Furrer/Müller-Chen, OR AT (Fn. 69), S. 560.

- 84 Urwyler (Fn. 75), S. 537.

- 85 Furrer/Müller-Chen, OR AT (Fn. 69), S. 560.

- 86 Furrer/Müller-Chen, OR AT (Fn. 69), S. 561.

- 87 Vgl. Fröhlich-Bleuler Gianni, Rechtsprechung zum Software-Vertragsrecht Eine Tour d' Horizon, Jusletter vom 24. Januar 2011, hrsg. von Wiegand Wolfgang/Montani Sarah/Kummer Franz, Bern 2011, S. 3 und ferner Fröhlich-Bleuler (Fn. 87), S. 4: «in der Lehre herrscht Uneinigkeit, wie ein Softwareüberlassungsvertrag zu qualifizieren ist und welche Bestimmungen analog Anwendung finden».

- 88 In Analogie zu Lohmann Melinda F., Roboter als Wundertüten – eine zivilrechtliche Haftungsanalyse, in: Aktuelle Juristische Praxis (AJP)/Pratique Juridique Actuelle (PJA), 02/2017, S. 152–162, hrsg. von Rusch Arnold F., Zürich 2017, S. 155.

- 89 Art. 8 ZGB.

- 90 Für weitere Ausführungen vgl. OFK/Bühler Roland/Art. 396 OR/Rz. 1, in: Kren Kostkiwic Jolanta/Wolf Stephan/Amstutz Marc/Frankhauser Roland (Hrsg.), OR Kommentar Schweizerisches Obligationenrecht, Orell Füssli Kommentar (OFK), 3. Aufl., Zürich 2016.

- 91 Es wäre auch möglich, dass hier eine andere umfassendere Beratungstätigkeit vereinbart wird, welche auch rechtliche Bereiche abdeckt, in denen nicht der Chatbot zur Anwendung gelangt.

- 92 Furrer/Müller-Chen, OR BT (Fn. 76), S. 282.

- 93 Furrer/Müller-Chen, OR BT (Fn. 76), S. 282.

- 94 HPK/Graham-Siegenthaler/Art. 398 OR/Rz. 11 und 24, in: Fischer Willi, Luterbacher Thierry (Hrsg.), Haftpflichtkommentar (HPK), Kommentar zu den schweizerischen Haftpflichtbestimmungen, 1. Aufl., Zürich/St. Gallen 2016.

- 95 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 11 und 14.

- 96 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 11., vgl. dazu Art. 400 Abs. 1 OR.

- 97 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 36 ff., Furrer/Müller-Chen, OR BT (Fn. 76), S. 285.

- 98 Der Aufbau der Prüfung erfolgt nach dem Prüfschema von Furrer/Müller-Chen, OR AT (Fn. 69), S. 571.

- 99 Furrer/Müller-Chen, OR BT (Fn. 76), S. 285.

- 100 Zum Begriff der positiven Vertragsverletzung vgl. Furrer/Müller-Chen, OR AT (Fn. 69), S. 569.

- 101 Furrer/Müller-Chen, OR BT (Fn. 76), S. 291.

- 102 CHK/Gehrer Cordey/Giger/Art. 398 OR/Rz. 9, in: Amstutz Marc et al. (Hrsg.), Handkommentar zum Schweizer Privatrecht (CHK), 3. Aufl., Zürich 2016.

- 103 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 40, vgl. auch Kap. 5.4.4 Verschulden.

- 104 CHK (Fn. 102)/Gehrer Cordey/Giger/Art. 398 OR/Rz. 9.

- 105 CHK (Fn. 102)/Gehrer Cordey/Giger/Art. 398 OR/Rz. 9.

- 106 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 47.

- 107 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 47.

- 108 Es gibt zu der hier behandelten Frage gemäss der hier vorhandenen Kenntnisse noch keine Präzedenz.

- 109 Eine Analoge Anwendung der Sorgfaltspflichten des Anwalts ginge nach der hier vertretenen Ansicht jedoch bedeutend zu weit, zu den Sorgfaltspflichten des Anwalts vergleiche namentlich Fellmann Walter, Haftung für fehlerhafte Rechtsberatung und Prozessführung, in: Aktuelle Entwicklungen im Haftungsrecht, Referate der Tagung Recht aktuell 2006 der juristischen Fakultät Basel, Editions Weblaw, S. 85–110, hrsg. von Jung Peter, Bern 2007, S. 90 ff.

- 110 Straub Wolfgang, Rechtliche Verantwortlichkeiten bei IT-Störungen, Luzerner Praxisforum vom 25. März 2003 Verletzliche Informations-Infrastrukturen, Luzern 2003, S. 18.

- 111 Straub (Fn. 110), S. 18.

- 112 Straub (Fn. 110), S. 18.

- 113 Straub (Fn. 110), S. 18.

- 114 Vgl. hierzu Art. 97 Abs. 1 OR: «sofern er nicht beweist, dass ihm keinerlei Verschulden zur Last falle».

- 115 Diese Pflicht lässt sich namentlich mit der Aufklärungspflicht begründen.

- 116 Furrer/Müller-Chen, OR AT (Fn. 69), S. 308.

- 117 Furrer/Müller-Chen, OR AT (Fn. 69), S. 308, vgl. ferner BGE 142 III 23 E. 4.1 und BGE 132 III 321 E.2.2.1.

- 118 Fellmann (Fn. 109), S. 88.

- 119 Fellmann (Fn. 109), S. 88.

- 120 Furrer/Müller-Chen, OR AT (Fn. 69), S. 308, vgl. ferner BGE 95 II 481 E. 12.

- 121 HPK (Fn. 94)/Graphics-Siegenthaler/Art. 398 OR/Rz. 59.

- 122 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 59.

- 123 BGE 142 III 433 E. 4.5, vgl. ferner BGE 123 III 110 E. 3a, sowie Furrer/Müller-Chen, OR AT (Fn. 69), S. 316.

- 124 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 40.

- 125 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 40.

- 126 Namentlich Fellmann (Fn. 110), S. 106.

- 127 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 41.

- 128 HPK (Fn. 94)/Graham-Siegenthaler/Art. 398 OR/Rz. 41.

- 129 HPK (Fn. 94)/Giger/Art. 97/Rz. 34.

- 130 Furrer/Müller-Chen, OR AT (Fn. 69), S. 351; vgl. ferner Müller Thomas, Die Haftung des Anwalts – Ausgewählte Aspekte, in: Anwalts Revue De L’Avocat, 11–12/15, 459–464, hrsg. von Schweizerischer Anwaltsverband und Stämpfli Verlag AG, Bern 2015 (zit. Müller, Haftung des Anwalts), S. 464.

- 131 Furrer/Müller-Chen, OR AT (Fn. 69), S. 353.

- 132 Furrer/Müller-Chen, OR AT (Fn. 69), S. 353.

- 133 Furrer/Müller-Chen, OR AT (Fn. 69), S. 356, vgl. ferner BGE 107 II 161 E. 7c.

- 134 Furrer/Müller-Chen, OR AT (Fn. 69), S. 356.

- 135 Furrer/Müller-Chen, OR AT (Fn. 69), S. 356.

- 136 Müller-Chen Markus, Vertragliche Haftung und Freizeichnungsmöglichkeiten des Beraters, in: Gauchs Welt: Recht, Vertragsrecht und Baurecht- Festschrift für Peter Gauch zum 65. Geburtstag, S. 507–518, hrsg. von Tercier Pierre, Zürich 2004, S. 512.

- 137 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 512.

- 138 Rusch Arnold F./Bornhauser Philip R., Korrektiv zur Freizeichnung von der Hilfspersonenhaftung, in: Aktuelle Juristische Praxis (AJP)/Pratique Juridique Actuelle (PJA), 10/2010, S. 1228–1238, hrsg. von Rusch Arnold F., Zürich 2010, S. 1228, hier wird davon ausgegangen, dass es sich beim Betreiben eines Chatbots nicht um ein obrigkeitlich konzessioniertes Gewerbe handelt, vgl. hierzu Art. 100 Abs. 2 OR.

- 139 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 512.

- 140 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 512; in diesem Kontext kann von einer mittelbaren Haftungsmodifikation gesprochen werden, vgl. hierzu Emmenegger Susan/Jegher Nicola/Graf Sereina, Für Hilfspersonen wird nicht gehaftet – oder doch? Art. 101 Abs. 2 OR im Lichte der Ungewöhnlichkeitsregel, in: Brücken bauen Festschrift für Thomas Koller, S. 177–193, Bern 2018, S. 182.

- 141 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 512.

- 142 Furrer/Müller-Chen, OR AT (Fn. 69), S. 146.

- 143 Furrer/Müller-Chen, OR AT (Fn. 69), S. 146: «Enthalten die AGB ungewöhnliche oder überraschende Klauseln?», vgl. ferner, Furrer/Müller-Chen, OR AT (Fn. 69), S. 146. Das Bundesgericht bejaht die Ungewöhnlichkeit einer Klausel dann, wenn sie zugleich subjektiv und objektiv ungewöhnlich ist, vgl. hierzu BGE 135 III 1 E. 2.1, BGE 109 II 452 E. 5b), ausführlicher Huguenin Claire, Obligationenrecht Allgemeiner und Besonderer Teil, 3. Aufl., Zürich 2017, Rz. 623.

- 144 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 518.

- 145 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 515.

- 146 BSK UWG/Thouvenin/Art. 8 UWG/Rz. 59, in: Hilty, Reto M./Arpagaus Reto (Hrsg.), Bundesgesetz gegen den unlauteren Wettbewerb (UWG), Basler Kommentar, Basel 2013.

- 147 BSK UWG (Fn. 146)/Thouvenin/Art. 8 UWG/Rz. 58; BSK OR/Zellweger-Gutknecht/Art. 1 OR/Rz. 65, in: Widmer Lüchinger Corinne/Oser David (Hrsg.), Obligationenrecht I. Basler Kommentar, Art. 1–529 OR, 7. Aufl., Basel 2019.

- 148 Zum Begriff des Konsumentenvertrages siehe BSK UWG (Fn. 146)/Thouvenin/Art. 8 UWG/Rz. 20, Rz. 79 ff.

- 149 Art. 8 UWG, BSK UWG (Fn. 146)/Thouvenin/Art. 8 UWG/Rz. 125 ff., zum Prüfungsablauf siehe BSK UWG (Fn. 146)/Thouvenin/Art. 8 UWG/Rz. 100 ff.

- 150 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 518, soweit ersichtlich ist diese Feststellung in der Lehre nicht unumstritten. Namentlich wird in BSK OR (Fn. 147)/Oser/Weber/Art. 398 OR/Rz. 35 davon ausgegangen, dass die Parteien «auch von der nach objektivierten Massstäben geschuldeten Sorgfalt vertraglich abweichen [dürfen], also mithin einen tieferen Sorgfaltsmassstab vorsehen» vorsehen können.

- 151 Müller-Chen, Vertragliche Haftung (Fn. 136), S. 518.

- 152 Hanke (Fn. 44), S. 218.

- 153 Gordon Clara-Ann/Lutz Tanja, Haftung für automatisierte Entscheidungen – Herausforderungen in der Praxis, in: Schweizerische Zeitschrift für Wirtschafts- und Finanzmarktrecht (SZW), 1/2020, S. 53–61, hrsg. von von der Crone Hans C. et al., Zürich 2020, S. 59.

- 154 Müller Melinda F., Roboter und Recht, in: Aktuelle Juristische Praxis (AJP)/Pratique Juridique Actuelle (PJA), 05/2014, S. 595–608, hrsg. von Rusch Arnold F., Zürich 2014 (zit. Müller, Roboter und Recht), S. 599.

- 155 Vgl. dazu die Ausführungen zu Kap.2.

- 156 Müller, Roboter und Recht (Fn. 154), S. 599.

- 157 Gordon/Lutz (Fn. 153), S. 59.

- 158 Gordon/Lutz (Fn. 153), S. 59.

- 159 Aufgrund des begrenzten Umfangs dieser Arbeit hat sich die Überprüfung auf diejenigen Zurechnungsnormen zu beschränken, welche im Kontext der Ausgangsstellung relevant sein könnte.

- 160 Namentlich in Bleskie (Fn. 30), S. 22 ff.

- 161 Müller, Roboter und Recht (Fn. 153), S. 599.

- 162 Müller, Roboter und Recht (Fn. 153), S. 601; Bleskie (Fn. 30), S. 23.

- 163 Namentlich Freytag Urs, Sicherheitsrechtliche Aspekte der Robotik, in: Sicherheit & Recht/Sécurité & Droit, 2/2016, S. 111–121, hrsg. von Bütler Michael/Schindler Benjamin/Sprecher Franziska/Sutter Patrick, Zürich/St. Gallen 2016, S. 119.

- 164 Vgl. hierzu Bleskie (Fn. 30), S. 23.

- 165 Janal Ruth, Die deliktische Haftung beim Einsatz von Robotern – Lehren aus der Haftung für Sachen und Gehilfen, in: Intelligente Agenten und das Recht, S. 139–162, hrsg. von Gless Sabine/Seelmann Kurt, Baden Baden 2016, S. 154.

- 166 Janal (Fn. 165), S. 155.

- 167 Bleskie (Fn. 30), S. 22.

- 168 Vgl. Lohmann (Fn. 88), S. 161.

- 169 Freytag (Fn. 163), S. 118 f.

- 170 Lohmann (Fn. 88), S. 161.

- 171 Bleskie (Fn. 30), S. 22.

- 172 Analog zu Simmler Monika, Maschinenethik und strafrechtliche Verantwortlichkeit, in: Handbuch Maschinenethik, S. 453–469, hrsg. von Bendel Oliver, Wiesbaden 2019, S. 12.

- 173 Wie gross diese Genauigkeit genau zu sein hat, kann mangels Präzedenz nicht beantwortet werden.

- 174 Emmenegger/Jegher/Graf (Fn.140), S. 192 vertreten die Ansicht, dass eine vollständige Haftungsfreizeichnung für Hilfspersonen mittels AGB als ungewöhnlich einzustufen ist.

- 175 Vgl. hierzu BSK OR (Fn. 147)/Oser/Weber/Art. 398 OR/Rz. 35.

- 176 Vgl. Fröhlich-Bleuler (Fn. 87), S. 3 f. und ferner Kap. 4.2.

- 177 Klaus/Jung (Fn. 26), Kap. 2.3.

- 178 Martinis, Entwicklungen im Rechtsmarkt (Fn. 10), S. 43, gemäss dem Terminus aus Kap. 2 handelt es sich um Unexplainable AI.

- 179 Kriesel (Fn. 25), S. 41.

- 180 Kriesel (Fn. 25), S. 41.

- 181 Scheufen Marc, Künstliche Intelligenz und Haftungsrecht: die e-Person aus ökonomischer Sicht, in: Wirtschaftsdienst Zeitschrift für Wirtschaftspolitik, 99. Jahrgang, Heft 6, S. 411–414, hrsg. von Leibniz-Informationszentrum Wirtschaft (ZBW), Kiel/Hamburg 2019, S. 412.

- 182 Scheufen (Fn. 181), S. 412.

- 183 Bleskie (Fn. 30), S. 24.