1.

«Verantwortungsbewusste Digitalisierung», RER-/LER-Formula sowie «KI(Recht)» & «AI(Law)» und Vertrauen ^

Das Thema der IRIS 2020 lautet «Verantwortungsbewusste Digitalisierung». Der vorliegende Beitrag konzentriert sich auf die sog. «künstliche Intelligenz» (Deutsch: KI)1/ «Artificial Intelligence» (Englisch: AI). Aus recht(swissenschaft)licher Sicht gilt: Weder für die Definition dieser KI/AI noch für ihre Funktionalitäten in der Mitwelt mit Menschen, Tieren und Pflanzen hat das (Verfassungs)Recht grammatisch Vorsorge getroffen. Konsequent adressiert dieser Beitrag Kernherausforderungen wie -agenden und verzichtet angesichts der Gigantonomie der Herausforderungen auf den Anspruch der umfassenden Auswertung von Literatur2- und Rechtsquellen. Bereits zu Beginn dieses Beitrags darauf hinzuweisen ist, dass AI(Law) in Zukunft aus der Trias «RER» (Englisch: LER – Lawful-Ethical-Robust) bestehen könnte. Vereinfacht: «Recht» – traditionell der Rechtswissenschaft zugeordnet; «Ethik» traditionell der Philosophie zugeordnet und «Robustheit» traditionell den Technikwissenschaften zugeordnet. Diese Trias erklärt die obige Klammer um «Recht» wie «Law» («KI(Recht)» & «AI(Law)»). Konsequent wird die Frage nach der (Be)Deutungshoheit dieser drei Kompetenzen (Recht – Ethik – Technologie) gestellt. Bereits zu Beginn dieses Beitrags ist vor einer AI-Governance zu warnen, die glaubt – angesichts fehlender normativer, insbesondere primärrechtlicher Rechtsinnnovationen auf EU- wie BRD-Ebene – «Ethik», «Robustheit» und «Vertrauen» zu ihren Grundlagen machen zu müssen. Anlass für diese Beobachtung wie Warnung ist die Verwendung des Adjektivs «vertrauenswürdig»3 im Kontext einer bis dato wenig detaillierten Definition der künstlichen Intelligenz und des Fehlens von primärrechtlichen Normierungen für ein «Dateneigentum» von natürlichen und juristischen Personen als «Rohstoff» für den Wertschöpfungsprozess KI. Hervorzuheben ist: sowohl «Vertrauen» in KI wie «verantwortungsbewusst» in Digitalisierung (Tagungstitel) adressieren die menschliche Psyche – und nicht zunächst die «Rationalität» wie Funktionalität menschlichen Verstandes.

2.1.

Dokumente der Kommission und der Expertengruppe (AI-HLEG) ^

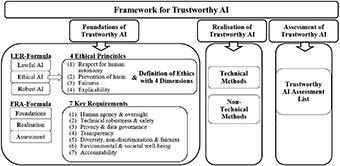

Grundlage dieses Beitrags sind 7 ausgewählte Dokumente4, und zwar drei Mitteilungen der Europäischen Kommission zu «AI for Europe» und eine Mitteilung zum Aufbau einer europäischen Datenwirtschaft. Die anderen drei Dokumente stammen von einer 52-köpfigen, internationalen, «Unabhängigen Hochrangigen Expertengruppe» (= Independent High-Level Expert Group on Artificial Intelligence – AI-HLEG), die «Ethikrichtlinien», ein «Definitionsdokument» und «Politik- und Investitionsempfehlungen» entworfen und verabschiedet hat. Grundsätzlich handelt es sich auch5 bei den Kommissions-Mitteilungen nicht um bindendes Recht6 – ohne, dass in diesem Beitrag weitere Ausführungen zur Rechtmäßigkeit dieser Quellen gemacht werden sollen. So ist nämlich nicht zu übersehen, dass eine grundsätzliche Umgestaltung unserer Welt eben nicht durch «soft law»7 rechtssicher erfolgen könnte. Die folgende Graphik beruht auf einer Textanalyse dieser EU-(Rechts-)Quellen:

2.2.

AI(Law) Framework der Expertengruppe (AI-HLEG) als Graphik ^

Abbildung 1: «Schmid: AI-Framework of AI-HLEG»

Im Überblick sichtbar wird: Die LER-Formula (Englisch: Lawful-Ethical-Robust; Deutsch: Recht-Ethik-Robustheit und RER-Formel) als Grundlage (Foundations) wird ergänzt durch ein Konzept der Um- und Durchsetzung wie Kontrolle (Realisation & Assessment) – hier als FRA-Formula8 (Foundations-Realisation-Assessment) präsentiert. Diese PPT-Folie stammt aus dem englischsprachigen Beitrag der Autorin zu einer ersten hessischen AI-Vorlesung. Deutlich wird, dass die LER-Formula sowohl durch technische, als auch durch nicht technische Maßnahmen implementiert wird (Realisation).

2.3.

KI(Recht)/AI(Law) – FRA-Formula der AI-HLEG ^

Mit der FRA-Formula wird die Trias Foundations, Realisation und Assessment umschrieben. Eine hervorragende Funktionalität von Recht ist sein Durchsetzungspotential angesichts mehrerer Parteien mit unterschiedlichen Rechts- und Gerechtigkeitsvorstellungen. Vor der «KI-Welt» ersparten uns der Rechtsstaat (BRD: Art. 19 Abs. 4; 20 und 28 Abs. 1 S. 1 GG) wie die «Rechtsunion» Vertrauensemotionalitäten – gab es doch den Rechtsweg. Auch begnügten wir uns nicht mit «Verantwortungsbewusstsein», sondern verlangten mit Zurechnungs-, Haftungs-, Vollstreckungs- und Mindestkapitalausstattungsregeln rechtlich verantwortetes Unternehmertum. Die Veränderung der «KI-Welt» derzeit ist eindeutig: wenn wir solchen Unternehmen und staatlichen Institutionen nicht trauen mussten und dies als Errungenschaft eines demokratischen und sozialen Rechtsstaats erlebten – dann sollen wir jetzt gegenüber KI Vertrauen entwickeln (gerade wenn die Risiken von «technischem Determinismus» evident sind). Wegweisend erscheint insofern der pilotierende und iterierende Prozess, den die Expertengruppe (AI-HLEG) verlangt: nämlich die Erstellung einer Bewertungsliste für KI («Assessment-List»)9. Damit wird aber auch eine singuläre Chance der «KI-Welt» deutlich: der Rechtsgehorsam durch Programmierung («Law is Code»10 (by default?)).

2.4.

RER-/LER-Formula sowie «KI(Recht)» & «AI(Law)» ^

Mit LER (Lawful-Ethical-Robust) wird die Multidisziplinarität der Gestaltungsherausforderung deutlich, die nach den hier ausgewählten 7 Dokumenten auf EU-Ebene eben nicht «nur» die Rechtskonformität verlangen. Über die «Lawfulness» hinaus wird die «ethische Vertretbarkeit» (Ethical) wie die (technische) «Robustheit» (Robustness) gefordert. Ein solches «(Legal) Design» erinnert die Autorin hinsichtlich der ersten beiden Elemente an ihre älteren Forschungen11 zum Unlauteren Wettbewerbsrecht in der BRD, dessen § 1 von 1909 – 2004 lautete: «Wer im geschäftlichen Verkehre zu Zwecken des Wettbewerbes Handlungen vornimmt, die gegen die guten Sitten verstoßen, kann auf Unterlassung und Schadensersatz in Anspruch genommen werden.».12 In einer digitalisierten Welt wird diese bekannte Dichotomie von Recht und Ethik (damals «gute Sitten») um eine technologische Grundanforderung ergänzt, die als «Robustheit» bezeichnet wird. Nach hier vertretener Meinung handelt es sich bei «Robustheit» um die Etablierung eines Äquivalents zum Rechtsstaatsprinzip (BRD: Art. 19 Abs. 4; 20 und 28 Abs. 1 S. 1 GG) im Cyberlaw – dem Prinzip der (IT-) Sicherheit.13

2.5.

«Ethik», Moral und Sitten – Langerwartete Definitionen und Relationen durch die AI-HLEG? ^

Wie § 1 UWG a.F. – und die bekannt «uferlose» Literatur – zeigen, ist ein Vorzug der KI-Welt, dass neue Terminologieanstrengungen erfolgen. Die AI-Expertengruppe (AI-HLEG) formuliert: «Ethics is an academic discipline which is a subfield of philosophy. In general terms, it deals with questions like «What is a good action?», «What is the value of a human life?», «What is justice?», or «What is the good life?». In academic ethics, there are four major fields of research: (i) Meta-ethics, mostly concerning the meaning and reference of normative sentence, and the question how their truth values can be determined (if they have any); (ii) normative ethics, the practical means of determining a moral course of action by examining the standards for right and wrong action and assigning a value to specific actions; (iii) descriptive ethics, which aims at an empirical investigation of people’s moral behaviour and beliefs; and (iv) applied ethics, concerning what we are obligated (or permitted) to do in a specific (often historically new) situation or a particular domain of (often historically unprecedented) possibilities for action. Applied ethics deals with real-life situations, where decisions have to be made under time-pressure, and often limited rationality. AI Ethics is generally viewed as an example of applied ethics and focuses on the normative issues raised by the design, development, implementation and use of AI. Within ethical discussions, the terms «moral» and «ethical» are often used. The term «moral» refers to the concrete, factual patterns of behaviour, the customs, and conventions that can be found in specific cultures, groups, or individuals at a certain time. The term «ethical» refers to an evaluative assessment of such concrete actions and behaviours from a systematic, academic perspective.»14

Man mag sich diesen Ethik-, Moral- und Sittendefinitionen und –relationen anschließen oder verschließen. Jedenfalls gibt es in Zukunft auch im Kontext von Corporate Ethics, Business Ethics, Company Ethics und im Kontext von (Corporate) Social Responsibility Indexes15 eine «erste Handreichung». Vom «soft law» der Kommission und der ihr eingesetzten Expertengruppe abgesehen ergibt eine AI-Recherche im «traditional law» – Fokus «Rechtsdurchsetzung» (also 3. Gewalt) – folgendes Ergebnis:

2.6.1.

AI in der Rechtsprechung ^

Eine englische Stichwortrecherche («artificial intelligence») bei Curia16 hat ergeben, dass 19 Rechtssachen (dort entweder «artificial» oder «intelligence» oder beides) genannt werden. Keine einzige Entscheidung des EuGH und des EuG scheint AI grammatisch zur Kenntnis zu nehmen.

2.6.2.

AI in den Schlussanträgen der Generalanwälte ^

In 4 Schlussanträgen von Generalanwälten wird AI – hiervon 2-mal in der Fußnote – genannt. Bereits 1987 werden Computer im Rahmen von Zolltarifstreitigkeiten erwähnt, die für wissenschaftliche Arbeiten an AI geeignet sind.17 2009 wird von Generalanwältin Sharpston bedacht, ob der Verordnungsgeber AI-Potential bei einer Regelung vor Augen hatte.18 2017 bestätigt Generalanwalt Wathelet den Transformationscharakter von AI.19 Ein vierter Schlussantrag wird folgend getrennt präsentiert, weil er von grundsätzlicher Bedeutung ist:

2.6.3.

Autonomiethese (Szpunar) und die Notwendigkeit von AI-Wettbewerb ^

2017 integriert Generalanwalt Szpunar (in einer Fußnote) in einem «Uber-Fall» Algorithmen in das Wettbewerbsrecht mit Literaturhinweisen auf AI: «For example, the use by competitors of the same algorithm to calculate the price is not in itself unlawful, but might give rise to hub-and-spoke conspiracy concerns when the power of the platform increases.»20. In der gleichen Fußnote verweist der Generalanwalt auf die Rechtssache Eturas and Others (21. Januar 2016)21 – eine Wettbewerbs- und Kartellrechtsstreitigkeit, die ein von mehreren Mitbewerbern genutztes Reisebuchungsportal zum Gegenstand hat. Der EuGH etabliert im Kontext dieser technologischen Vernetzung (der Angebote) konkurrierender Mitbewerber ein Autonomieerfordernis: ‹As a preliminary point, it is necessary to recall the Court’s case-law that each economic operator must determine independently the policy which it intends to adopt on the common market. Such a requirement of autonomy [...].›22 Hervorzuheben ist: Wenn es im Kartell- und Wettbewerbsrecht ein Rechtsprinzip der Unabhängigkeit gibt, dann muss es in einem «Digital Single Market» auch voneinander unabhängige (künstliche) Intelligenzen geben. Andernfalls droht die Existenz einer «vertrauenswürdigen KI» die traditionellen («traditional law») Wettbewerbsprinzipien des Binnenmarkts (Art. 26 Abs. 2 AEUV) zu konterkarieren. Zusammengefasst: freier Wettbewerb einerseits und vertrauenswürdige KIs andererseits sind die Absage an Alleinstellungsbehauptungen, dass es nur eine vertrauenswürdige KI geben kann. Sie bereiten vor auf die Erkenntnis, dass im EU-Rahmen erstrebenswerte – und vermutlich fördermittelfähige – KI’en eben «trustworthy» sein sollen.

3.1.

Gutachten der BRD-Datenethikkommission vom 23. Oktober 2019 ^

Auf deutscher Ebene hervorzuheben ist das – aus Cyberlawperspektive – jahrzehntelang erwartete Gutachten23 der Datenethikkommission vom 23. Oktober 2019, das in der 19. Legislaturperiode eine Koalitionsvereinbarung von CDU/CSU und SPD erfüllt. Die Trias Recht, Ethik und Technologie ist genauso prägend wie die europäisierende Internationalisierung von AI – ihrer rechtlichen, ökonomischen und technischen Rahmenbedingungen als Voraussetzung für einen «Digital Single Market».24 Der Schwerpunkt dieses Beitrags liegt deswegen auf der EU-Ebene.

3.2.

Suche nach Einheit in der Vielfalt – Grundlagen und sektorspezifisches KI(Recht) ^

Grundsätzlich darauf hinzuweisen ist, dass sowohl auf EU-Ebene wie auch auf deutscher Ebene unterschiedliche Ethikvorstelllungen entwickelt wie dokumentiert werden. Zu unterscheiden sind funktionalitätsübergreifende Anforderungen – Foundations – einerseits und sektorspezifische Anforderungen andererseits. So ist etwa auf BRD-Ebene bereits in der 18. Legislaturperiode ein Bericht zur Ethik des autonomen Fahrens25 erstellt worden. Der folgende Beitrag konzentriert sich auf allgemeine Grundlagen für KI – und nicht die funktionalitätsspezifischen Details etwa von «Luft»Drohnen oder «Straßen»Drohnen (Autos). Auch die Kommission erkennt, dass sich sektorspezifische(s) KI(Recht) konsolidieren wird und stellt in Aussicht, dass die Aufsicht über die Durchsetzung der RER-Anforderungen skaliert wird: «Diese Anforderungen sollen zwar generell für alle KI-Systeme in verschiedenen Umfeldern und Branchen gelten, bei ihrer konkreten und verhältnismäßigen Umsetzung sind aber der jeweilige spezifische Anwendungskontext und die möglichen Folgen zu berücksichtigen. So wäre beispielsweise eine KI-Anwendung, die ein unpassendes Buch vorschlägt, weit weniger gefährlich als etwa eine Anwendung, die eine falsche Krebsdiagnose stellt, und könnte daher einer weniger strengen Aufsicht unterliegen.»26

3.3.

Fokussierung auf die deutsch-europäische Perspektive – die «Deutsche Verfassungsidentität» und die Notwendigkeit von (Verfassungs)Rechtsänderung(en)? ^

Der vorliegende Beitrag konzentriert sich im «Mehrebenenmodell»27 auf die deutsch-europäische Perspektive und verzichtet bewusst auf völkerrechtliche28 und rechtvergleichende Analysen. Die ungewöhnliche Bezeichnung «deutsch-europäisch» soll darauf hinweisen, dass es sich nicht um eine Analyse aus anderer mitgliedsstaatlicher Rechtsperspektive handelt. Deswegen ist das Grundgesetz wie die «Deutsche Verfassungsidentität» (Art. 79 Abs. 3, 23 Abs. 1 S. 3, 1 und 20 GG) in der Rechtsprechung des Bundesverfassungsgerichts29 Ausgangs- und Endpunkt der rechtlichen Analyse einer deutschen Staatsrechtslehrerin («ich»).

Nicht nur die «deutsche Verfassungsidentität», sondern auch Verfassungsänderungen hinsichtlich ihres «Obs» und «Wies» müssen wissenschaftlich, politisch und rechtlich entschieden wie gestaltet werden («Legal Design»), damit unsere Welt durch KI bereichert werden kann. Klar sein muss: Die Alternative zur Schaffung von neuem (Verfassungs-)Recht ist die Auslegung des existierenden Rechts (hier als «traditional law» bezeichnet). Bei letzterem wird strittig werden, inwieweit die Gestaltungsfreiheit des einfachen Gesetzgebers reicht bzw. die Verschiebung der (Interpretations)Macht auf die Gerichte (der 3. Gewalt) dem Rechtsstaatsprinzip und der Wesentlichkeitstheorie30 genügt. Dieses a priori Verständnis ist zu teilen, weil das Grundgesetz von 1949 eine Mitwelt mit (Maschinen mit) KI nicht kennen konnte. Funktionsvorbehalte für menschliche Intelligenz werden (Rechtsgedanke des Art. 33 Abs. 4, 5 GG bei der Wahrnehmung von Hoheitsaufgeben durch Beamte) zu erwägen sein. Darüber hinaus werden vielleicht sogar Verfassungsänderungen notwendig sein, wenn Freiheitsrechte nur noch in der Mensch-Maschine-Welt ausgeübt werden können: etwa die Ausprägung der allgemeinen Handlungsfreiheit (Art. 2 Abs. 1 GG) des «Reitens im Walde»31 zusammen mit «Luft»Drohnen, die Pferd und Reiter32 filmend begleiten und von Fußgängern zu tolerieren sind. Darüber hinaus gibt es – absehbar – Diskurs- und Positionierungsbedarf:

4.

Eine veränderte Welt, Elektrizitätsmetapher und die Definitionsherausforderungen «Künstlicher Rationalität» ^

4.1.

Eine veränderte Welt: KI als Elektrizität? ^

Die Kommission wählt eine undifferenzierte Elektrizitätsmetapher für eine «KI-Realität»33: ‹Wie die Elektrizität in der Vergangenheit ist es jetzt die künstliche Intelligenz (KI), die unsere Welt grundlegend verändert.›34 Bereits 2017 bejaht auch der Schlussantrag von Generalanwalt Wathelet im Kontext von «Legal Tech»«[...] artificial intelligence programmes inevitably transform the way in which the profession and its practice are conceived.»35

4.2.

Eine veränderte Welt: KI als Produkt von (Kern-)Energie? ^

Aus deutscher energierechtlicher Sicht ist diese Gleichstellung wenig aussagekräftig, weil sie nicht zwischen unterschiedlichen Energieerzeugungstechnologien – Windkraft, Kraft-Wärme-Kopplung, Wasserkraft, Braun- und Steinkohle, Solar- und Kernenergie differenziert. Davon hängt auch ab, ob man KI-Veränderungspotenzial als «Transformation», «Evolution» oder «Revolution» (eigenes Akronym: (R)Evolution) bezeichnen will, soll, kann, muss. Jedenfalls der Kommission auf EU-Ebene scheint klar zu sein, dass diese Umgestaltung der Welt in eine «KI getriebene Welt»36 (in der Terminologie der AI-HLEG; «Game-Changer»37 – in der Terminologie der Kommission) eine neue, transdisziplinäre Wissenschaft wie Praxis erfordert.

4.3.

Vertrauensbildung durch eine «KI-Marke» – «HCAI» und die LER-Formula ^

Solodisziplinäre juristische Expertise reicht evident nicht aus, um den «Anforderungen» der Kommission an die neue «Marke» «Human-Centric Artificial Intelligence» («HCAI») zu genügen: «Durch das Bemühen um eine auf den Menschen ausgerichtete KI, die auf Vertrauen beruht, gewährleisten wir, dass unsere gesellschaftlichen Grundwerte gewahrt bleiben und Europa und seine Industrie als Vorreiter auf dem Gebiet der innovativen KI eine unverwechselbare Marke schaffen können, die überall auf der Welt Vertrauen genießt.»38 Nach dem von der KI-Expertengruppe im April 201939 zugrunde gelegten Strategiekonzept braucht es die Trias Recht, Ethik und Robustheit (hier als RER-Formel bezeichnet). Diese RER-Formel/LER-Formula hat sich im April 2019 die Kommission in einer Mitteilung zu Eigen gemacht.40 Die unabweisbare Konsequenz ist, dass sich in der KI(Rechts)Wissenschaft zumindest rechtliche, ethische (im weiteren Sinne) und technologische Kompetenzen multi- und transdisziplinär vereinen. Diese Entwicklung ist von der Autorin («ich»), die an der Begründung einer neuen Wissenschaftsdisziplin (Cyber(rechts)wissenschaft – Cyberscience) – arbeitet, vorhergesehen worden.41 Mit den gegenwärtigen AI-Konzepten auf europäischer Ebene ist diese Transdisziplinarität wie disziplinübergreifende Konkurrenz genauso ausweglos wie wegbereitend. Wissenschaftskonkurrenzen bereiten auf konkurrierende Definitionen voraus:

5.1.

Notwendigkeit des Plurals – Binnenmarktorientiert und Autorenreflektiert ^

Auch wenn man der kartell- und wettbewerbsrechtlichen Argumentation (s.o.) zu der Binnenmarktnotwendigkeit von autonomen wie konkurrierenden KIs nicht folgt, ist festzuhalten: Kommission und die von ihr eingesetzte AI-HLEG differieren in der Definition von KI. Auch insoweit ist der Plural gerechtfertigt.

5.2.

Definition der Kommission ^

Grundsätzlich festzuhalten ist, dass die Kommission eine sehr weite und bisweilen wertende KI-Definition wählt: «künstliche Intelligenz (KI) bezeichnet Systeme mit einem «intelligenten» Verhalten, die ihre Umgebung analysieren und mit einem gewissen Grad an Autonomie handeln, um bestimmte Ziele zu erreichen. [...] KI nutzen wir täglich, um z.B. Texte zu übersetzen, Untertitel in Videos zu erzeugen oder unerwünschte E-Mails zu blockieren. Viele KI-Anwendungen benötigen für eine optimale Funktionsweise Daten. Sobald sie gut funktionieren, können sie Entscheidungen im jeweiligen Bereich verbessern und automatisieren. [...].»42 Die Einzelheiten sollen hier nicht näher beleuchtet werden, aber darauf hinzuweisen ist: je weiter (und anspruchsloser) der KI-Begriff und je unbestimmter er ist, desto wahrscheinlicher ist eine Nichtachtung der Menschenwürde wie «Verwässerung» (dilution argument) des Begreifens von menschlicher «Intelligenz».

5.3.

Definition der AI-HLEG – zur «Künstlichen Rationalität» (eigene Terminologie) ^

Die Definition, in der sich die Expertengruppe (AI-HLEG) im April 2019 von der Kommissionsdefinition aus dem April 2018 distanziert, lautet: «Artificial intelligence (AI) systems are software (and possibly also hardware) systems designed by humans that, given a complex goal, act in the physical or digital dimension by perceiving their environment through data acquisition, interpreting the collected structured or unstructured data, reasoning on the knowledge, or processing the information, derived from this data and deciding the best action(s) to take to achieve the given goal. AI systems can either use symbolic rules or learn a numeric model, and they can also adapt their behaviour by analysing how the environment is affected by their previous actions. [...] As a scientific discipline, AI includes several approaches and techniques, such as machine learning (of which deep learning and reinforcement learning are specific examples), machine reasoning (which includes planning, scheduling, knowledge representation and reasoning, search, and optimization), and robotics (which includes control, perception, sensors and actuators, as well as the integration of all other techniques into cyber-physical systems).»43

Hervorzuheben ist, dass die Expertengruppe die multidisziplinäre Perspektive wie die «Unbestimmtheit» bereits des Intelligenzbegriffs kennt.44 In respektvoller Weise wird mitgeteilt, dass ein wichtiges Standardwerk über KI die Terminologie der «Rationalität» – und eben nicht der Intelligenz – als charakteristisch erachtet.45 Dass der «Kunstbegriff» sich in deutscher, verfassungsrechtlicher Perspektive nahezu jeder (außer der rechtlichen) Konkretisierung entzieht, darf als bekannt vorausgesetzt werden.46 Inspiriert durch die AI-HLEG wird hier vorgeschlagen, «Künstliche Rationalität» als Terminologie derzeit47 zu Grunde zu legen. Mit der Verwendung des Adjektivs «künstlich» wird dem Kreativitätspotenzial dieser Hochtechnologie Respekt erwiesen.

5.4.

«Natürliche» im Gegensatz zu künstlicher Intelligenz? ^

Sprachlogisch ist einsichtig, dass zwei Begriffe – K und I – zwei Definitionsanstrengungen verlangen. Worin besteht die «Kunst» und was soll die «Intelligenz» sein. Hervorzuheben ist, dass wir traditionell «Intelligenz» in Verbindung mit Menschen und Tieren verwenden. Beide Spezien sind durch Autonomie wie Universalität gekennzeichnet – sie konnten in der Vergangenheit stromunabhängig (Autonomiedetail) sämtliche Herausforderungen von Geburt, Leben und Tod bewältigen (Universalität). Die Gleichstellung im Substantiv «Intelligenz» dieser bekannten Intelligenzen mit «Sprachassistenten, Bildanalysesoftware, Suchmaschinen, Sprach- und Gesichtserkennungssysteme, [...] moderne Roboter, autonome Pkw, Drohnen oder Anwendungen des «Internet der Dinge»48 – wie es die Kommission 2018 tut – bereitet auf die Herausforderung zur Kritik vor. Die undifferenzierte Gleichstellung von Rationalität mit Intelligenz – siehe oben – droht allein begrifflich das Verständnis von menschlicher Intelligenz zu devaluieren.

5.5.

«Rationalität», «menschliche Intelligenz», Autonomie- und «Funktionalitätsdifferenzierung» ^

Deswegen wird vorgeschlagen, nicht «KI-getrieben» natürliche Intelligenz (NI) als Terminologie zugrunde zu legen (siehe den Titel), sondern «menschliche Intelligenz» (dann bleibt auch der Respekt vor wie die Differenzierung von tierischer (oder pflanzlicher?) Intelligenz erhalten). Darüber hinaus sollten KR-Konzepte (Künstliche Rationalität) funktionsdifferenziert skaliert werden. Es gibt eben – wie etwa beim autonomen Fahren49 – unterschiedliche Autonomiegrade und es gibt unterschiedliche Funktionalitäten – wie ein «Auto» oder eine «Luftdrohne» oder ein «Saug-, Mäh- oder Pflegeroboter». Darüber hinaus gibt es unterschiedliche Qualitäten der (Hoch-)Technologie – etwa die «Androidin» Elenoide50.

6.

GoCore! – Priorisierungsagenden ^

Die Autorin sucht seit 2014 mit der GoCore! Initiative51, die Kernherausforderungen zu identifizieren und den Weg zur CYBERSCIENCE (Cyber(Rechts-)wissenschaft) zu bahnen. Ein Milestone war die Etablierung einer Forschungsagenda in 2014 (vorgestellt auf der IRIS 2016)52, die als Basics Nr. VIII. (von XIII) «Automatisierung und Mensch-Maschine-Interaktion» auch53 KI fokussiert. Darüber hinaus wird (IT-)Sicherheit bereits damals als Äquivalent zum Rechtsstaatsprinzip qualifiziert und eine Verfassungsergänzung erwogen. Als Ergebnis dieses Beitrags plädiert die Autorin für drei GoCore!-AI-Agenden:

(1) Das Verhältnis von Recht und Ethik – zwei Elemente der RER-Formel – sind in Iterationsprozessen allzeitig und überall zu überprüfen. Voraussichtlich entwickeln die Volkrepublik China wie die Vereinigten Staaten von Amerika unterschiedliche Ausprägungen von «Ethik» und Europa begibt sich auf den sog. «dritten Weg». 54 Auch Erkenntnisse über «Ethik» werden also verbreitert wie vervielfältigt werden müssen.

(2) Für eine Positionierung auf dem globalen Markt ist die Interoperabilität von Rechtssystemen ständige Herausforderung. Die drängende Frage für KI in 2019 nach dem «Dateneigentum» neuer Bürger (der Cybercitizen im Cyberstate/der Cyberunion) wird vorhersehbar Recht und Ethik in Konkurrenz zueinander setzen. «Dateneigentum» in der Gegenwart und der Zukunft muss deswegen rechtswissenschaftliche Kernherausforderung werden – (Rechtsgedanke des Art. 14 Abs. 1 S. 1 GG) und/oder Allgemeinwohlexegese (Rechtsgedanke des Art. 14 Abs. 1 S. 2, Abs. 2 und 3 GG). Grundsätzlich ist inspiriert durch die Elektrizitätsmetapher auch über eine wirtschaftliche Teilhabe der «Datensubjekte» 55 zu streiten 56: Warum sollen in der Elektrizitätswirtschaft private Einspeiser – sog. «Prosumer» 57– eine Einspeisevergütung erhalten und in der Datenwirtschaft die «Datensubjekte» nicht? (Inter-)Nationale Ethikkontroversen vermögen diese grundsätzliche Kapitalismus- 58 wie Sozialisierungsherausforderung (Art. 15 GG) jedenfalls für die BRD nicht zielführend zu bewältigen. Es steht die Frage einer Verfassungsänderung durch Einführung neuer Grundrechte, Staatsziele, von Instituts- und/oder institutionellen Garantien an. Weil alle Einzelheiten – insbesondere die jüngste Aufsatz- und Archivliteratur aus 2017 ff. – hier nicht geteilt werden können, wird die Kernforderung einer (V)Erfassung eines «Cyberstate» und einer «Cyberunion», die äquivalent zum «traditional law» der Gegenwart und Vergangenheit Freiheit, Sicherheit, und Recht garantiert (vgl. Art. 67 Abs. 1 AEUV), erhoben.

(3) Wenn eine Hybridwelt, die das Miteinander wie Gegeneinander von menschlicher wie künstlicher Intelligenz voraussetzt, die globale Zukunft ist – dann muss KI (Aus-)Bildungsinhalt in allen Altersstufen der BRD- wie Unionsbürger werden. Andernfalls droht – wie im BRD-Kernenergierecht von Kalkar I 59 bis Atomkonsens II 60– die teure und im Prozess ineffiziente, schwer zu ertragende wie schwierig zu erlangende Erkenntnis, dass ein demokratischer Rechtsstaat diese Risiken einer Hochtechnologie nicht zu sichern vermag wie seine Bürger sie nicht zu akzeptieren vermögen. Mit Atomkonsens II hat das BVerfG die Gesetzgebungsmehrheit, die sich außerstande sah, die Bewältigung dieser Herausforderungen ihren Wählern zu vermitteln, unterstützt.Möge dieses (negative) Erfahrungskapital im Umgang mit Hochtechnologie in der Vergangenheit uns befähigen, im «GoCore! Neuland» der «KI getriebenen Welt» die Chancen nachhaltig und wahrhaftig zu ermitteln wie zu testen. Vorhersehbar ist: die «KI-Brille» wird uns Eigenschaften wie Funktionalitäten wie Vorzüge menschlicher Intelligenz zeigen, die uns vielleicht nicht mehr so selbstverständlich sind. Mögen wir in der Lage sein, die besten Leistungen aller Intelligenzen dergestalt zu vereinen, dass die Risiken und Gefahren – insbesondere menschlichen Fehlverhaltens 61– minimiert werden.

- 1 Wirtschaftsinformatisch orientiert: Buxmann/Schmidt (Hrsg.), Künstliche Intelligenz, 2019, mit Erfahrungsberichten etwa zu SAP (S. 41f.), Amazon (S. 63ff.) sowie zu branchenübergreifenden KI Lösungen (S. 119 f.).

- 2 Auch als Konsequenz der Volatilität wissenschaftlicher Erkenntnisse für einen globalen und dynamischen Erkenntnisprozess, der selbst in der medialen Berichterstattung eine immer größere Rolle spielt. Siehe etwa «TÜV für Künstliche Intelligenz» in F.A.Z. vom 13.11.2019, S. 16, die über ein «KI-Observatorium» beim Bundesministerium für Arbeit und Soziales berichtet wie auch in der wissenschaftlichen Literatur jüngst Martini, Blackbox Algorithmus – Grundfragen einer Regulierung Künstlicher Intelligenz, 2019.

- 3 «Building Trust in Human-Centric Artificial Intelligence», COM(2019)168 final, 08.04.2019 («HCAI-COM-I-2019»).

- 4 Auf europäischer Ebene handelt es sich um 4 Mitteilungen der Europäischen Kommission und 3 Dokumente (Deliverables) der Independent High-Level Expert Group on AI (AI HLEG) aus den Jahren 2017–2019 – präsentiert jeweils in zeitlicher Reihenfolge und in eigener Akronymologie: «Building a European Data Economy» COM(2017)9 final, 10.01.2017 («EDE-COM-I-2017»); «Artificial Intelligence for Europe» COM(2018)237 final, 25.04.2018 («AIfE-COM-I-2018»); «Coordinated Plan on Artificial Intelligence» COM(2018)795 final, 07.12.2018 («CPAI-COM-II-2018»); «Building Trust in Human-Centric Artificial Intelligence» COM(2019)168 final, 08.04.2019 («HCAI-COM-I-2019»). Die von der AI-HLEG veröffentlichen Dokumente sind «Ethics Guidelines for Trustworthy AI», 08.04.2019 («EGEGfTAI-I-2019»); «A Definition of AI: Main capabilities and disciplines», 08.04.2019 («EGDoAI-I-2019») und «Policy and Investment Recommendations for Trustworthy AI», 26.06.2019 («EGPaIRfTAI-I-2019»).

- 5 Die Ethikleitlinien dieser Expertengruppe haben in der Kommissionsmitteilung (HCAI-COM-I-2019, S. 4) «unverbindlichen Charakter» und sollen «daher als solche keine neuen rechtlichen Verpflichtungen» begründen.

- 6 Nettesheim in: Grabitz/Hilf/Nettesheim (Hrsg.), Das Recht der Europäischen Union, Band I, Art. 288 AEUV Rn. 211.

- 7 Knauff, Der Regelungsverbund: Recht und Soft Law im Mehrebenensystem, 2010, S. 325–340.

- 8 Cave: «FRA» (Foundations, Realisation, Assessment) ist zu unterscheiden von der «Fundamental Rights Agency» und ihren Deliverables zu AI. In «traditional law» trägt diese Agentur das Akronym «FRA», die sich in vielen Veröffetnllichungen auch mit AI auseinandersetzt (zu finden unter der Webpage von FRA, https://fra.europa.eu/en/about-fra/register-of-documents [20.11.2019]).

- 9 Siehe «Ethics Guidelines for Trustworthy AI», 08.04.2019 (EGEGfTAI-I-2019), S. 26–31, für die «Trustworthy AI Assessment List» (Pilot Version).

- 10 Vgl. Gantner, IRIS 2018 («Code is Law» aber «Is Law Code»?) https://jusletter-it.weblaw.ch/issues/2018/IRIS/-code-is-law--aber--_c692026243.html (19.11.2019). Siehe demnächst (2020) 79. Staatsrechtslehrertagung 2019: Öffentliches Recht und Privatrecht, Schmid im Rahmen der [...] Diskussionen.

- 11 Schmid (1998), Cyberlexonomics – Grundlagendokument: «Werbung als Meinung? (9/2014), S. 189f., http://www.cyberlexonomics.de/index.php/grundlagendokument (20.11.2019).

- 12 Siehe auch die geltende Fassung von § 138 Abs. 1 BGB.

- 13 Schmid, CyLaw-Report XXXVI: Der kleinste gemeinsame Nenner – 13 Basics zum Cyberlaw? [«Cyberlaw All 2 – 2014»], Basics IX von XIII. In: CyLaw-Report, 36. TU Darmstadt, Darmstadt 2016, http://tuprints.ulb.tu-darmstadt.de/5323/ (18.11.2019).

- 14 «Ethics Guidelines for Trustworthy AI», 08.04.2019 (EGEGfTAI-I-2019), S. 37; Hervorhebungen durch die Autorin.

- 15 BGBl I 2017, S. 802 ff – Gesetz zur Stärkung der nicht finanziellen Berichterstattung der Unternehmen in ihren Lage- und Konzernlageberichten (CSR-Richtlinie-Umsetzungsgesetz) und Richtlinie 2014/95/EU L 2014, 330/1.

- 16 http://curia.europa.eu/juris/recherche.jsf?language=en (19.11.2019).

- 17 EuGH, Urteil vom 21. Januar 1987, Control Data/Kommission, C-13/84, ECLI:EU:C:1987:16.

- 18 Schlussanträge von Generalanwältin Sharpston vom 29.06.2010, Commission v Bavarian Lager, C-28/08 P, ECLI:EU:C:2009:624, Fn. 64.

- 19 Schlussanträge von Generalanwalt Wathelet vom 09.02.2017, Lahorgue, C-99/16, ECLI:EU:C:2017:107, S. 1 Para 2.

- 20 Schlussanträge von Generalanwalt Szpunar vom 11.05.2017, Asociación Profesional Elite Taxi, C-434/15, ECLI:EU:C:2017:364, Fn. 23.

- 21 EuGH, Urteil vom 21.01.2016, Eturas and Others, C-74/14, ECLI:EU:C:2016:42.

- 22 EuGH, Urteil vom 21.01.2016, Eturas and Others, C-74/14, ECLI:EU:C:2016:42, Rn. 27.

- 23 BRD-DEK-GA-2019, https://datenethikkommission.de/gutachten/ (17.12.2019).

- 24 BRD-DEK-GA-2019, S. 226 f.

- 25 Ethik-Kommission (eingesetzt durch den Bundesminister für Verkehr und digitale Infrastruktur), Automatisiertes und Vernetztes Fahren, Juni 2017, https://www.bmvi.de/SharedDocs/DE/Publikationen/DG/bericht-der-ethik-kommission.pdf?__blob=publication-File (19.11.2019).

- 26 HCAI-COM-I-2019, S. 4, Hervorhebungen durch die Autorin.

- 27 Eigene Terminologie.

- 28 Siehe etwa das Internet Governance Forum der Vereinten Nationen, Berlin, Deutschland – Applying Human Rights and Ethics in Responsible Data Governance and Artificial Intelligence (27.11.2019) – Workshop.

- 29 Zur Vorratsdatenspeicherung: BVerfG, Urteil vom 02.03.2010, 1 BvR 256/08, Rn. 218 (mit Verweis auf BVerfG, Urteil vom 30.06.2009, 2 BvE 2/08, juris, Rn. 240).

- 30 Vgl. Maunz/Dürig/Herdegen, 87. EL März 2019, GG Art. 1 Abs. 3 Rn. 24 m.w.N.

- 31 BVerfG, Urteil vom 06.06.1989, 1 BvR 921/85, BVerfGE 80, 137.

- 32 Die Verwendung männlicher Sprache erfolgt im Interesse von Klarheit, Kürze und Einfachheit (KKE-Formel) verbunden mit der Bitte, nicht das grammatische Maskulinum auf das biologische Geschlecht zu reduzieren.

- 33 AIfE-COM-I-2018, S. 1.

- 34 CPAI-COM-II-2018, S. 1.

- 35 Schlussanträge von Generalanwalt Wathelet vom 9.02.2017, Lahorgue, C-99/16, ECLI:EU:C:2017:107, S. 1 Para 2.

- 36 EGPaIRfTAI-I-2019, S. 49.

- 37 AIfE-COM-I-2018, S. 4.

- 38 HCAI-COM-I-2019, S. 10, Hervorhebungen durch die Autorin.

- 39 EGEGfTAI-I-2019, S. 2.

- 40 HCAI-COM-I-2019, S. 4.

- 41 Abstract zum Inhalt der Vorlesung Cyberlaw (Recht der Informationsgesellschaft) an der TU Darmstadt, Ziff. V. «In a Nutshell»: Six Basics, https://www.cylaw.tu-darmstadt.de /lehre_3/lehrveranstaltungen_2/cyberlaw_i_recht_der_informationsgesellschaft_i_informations_und_datenschutzrecht_i_2/cyberlaw_i_recht_der_informationsgesellschaft_i_informations_und_datenschutzrecht_i_1.de.jsp (20.11.2019).

- 42 AIfE-COM-I-2018, S. 1, Hervorhebungen durch die Autorin.

- 43 EGDoAI-I-2019, S. 6.

- 44 EGDoAI-I-2019, S. 1.

- 45 EGDoAI-I-2019, S. 1 Fn. 2 mit Verweis auf Russell/Norvig, Artificial Intelligence: A Modern Approach, 3rd edition, 2009.

- 46 BVerfG, Urteil vom 13.06.2007, 1 BvR 1783/05, Rn. 61 ff., zusammenfassend: Maunz/Dürig/Scholz, 87. EL März 2019, GG Art. 5 Abs. 3 Rn. 113 ff.

- 47 Für «Künstliche Intelligenz» scheint derzeit vor allem das Science-Fiction Genre Beispiele zu liefern (vgl. «Real Humans», eine schwedische Science-Fiction-Dramaserie aus 2012).

- 48 AIfE-COM-I-2018, S. 1.

- 49 Siehe im Überblick SAE Standards News: J3016 automated-driving graphic update vom 07.01.2019 https://www.sae.org/news/2019/01/sae-updates-j3016-automated-driving-graphic (18.11.2019). Grundlegend auch Wagner in: Oppermann/Stender-Vorwachs (Hrsg.), Autonomes Fahren, Rechtsfolgen, Rechtsprobleme, technische Grundlagen, 1. Aufl 2017, S. 14–17 und im selben Oppermann, S. 177–178.

- 50 «Meine Kollegin die Roboterin», F.A.Z. 10.09.2019, S. 32.

- 51 www.gocore.wi.tu-darmstadt.de (18.11.2019), «GoCore!» steht als Akronym für die drei Begriffe Governance, Compliance & Regulation.

- 52 Schmid, CyLaw-Report XXXVI: Der kleinste gemeinsame Nenner – 13 Basics zum Cyberlaw? [«Cyberlaw All 2 – 2014»]. In: Cy-Law-Report, 36. TU Darmstadt, Darmstadt 2016. http://tuprints.ulb.tu-darmstadt.de/5323/ (18.11.2019) und dieselbe: Forschungsmatrix für eine globale Cyberlaw-Agenda – «Cyberlaw All 4 – 2016» in Schweighofer/Kummer/Hötzendorfer/Borges (Hrsg.), Netzwerke – Tagungsband des 19. Internationalen Rechtsinformatik Symposions (IRIS 2016), S. 441 – 448 (in der Printausgabe).

- 53 Siehe auch zum «coboteer» – https://www.safearoundrobots.com/getcovr (18.11.2019).

- 54 BRD-DEK-GA-2019, S. 276 f.

- 55 Diese Terminologie wird hier verwendet, weil die DSGVO (Art. 4 Nr. 11) «nur» «betroffene Personen» kennt, die hinsichtlich der sie «betreffenden Personen bezogenen Daten» ihr Einverständnis erklären können.

- 56 Aus der Rechtsprechung im einstweiligen Rechtsschutz ECLI:DE:OLGBB:2019:1106.4U123.19.00. Kategorisch verneinend die Vorsitzende des dt. Digitalrates Suder, «Teilt eure Daten!» in F.A.Z., 03.11.2019, S. 23; Determann, Kein Eigentum an Daten, MMR 2018, 277 und Stender-Vorwachs/Steege, Wem gehören unsere Daten?, NJOZ 2018, 1361, 1367. Differenzierend etwa der Bericht der Arbeitsgruppe «Digitaler Neustart» der Konferenz der Justizministerinnen und Justizminister der Länder vom 15.05.2017, https://www.justiz.nrw.de/JM/schwerpunkte/digitaler_neustart/zt_bericht_arbeitsgruppe/bericht_ag_dig_neustart.pdf (13.11.2019), S. 97–98, die die Notwendigkeit von Time Management (S. 97) erkennt wie auch einen «Flickenteppich» im Zivilrecht (S. 98, Ergebnis) als ein «hinreichend geschlossenes Schutzsystem» bezeichnet. Nicht eindeutig die BRD-DEK, die eine Teilhabe der «Datensubjekte» verlangt (die fehlende Eindeutigkeit wird wahrgenommen von Sangi «Die gestaffelten Algorithmen», F.A.Z., 06.11.2019 S. N2). Kategorisch fordernd: Fezer, «Studie Repräsentatives Dateneigentum – Ein zivilgesellschaftliches Bürgerrecht», https://www.jura.uni-konstanz.de/typo3temp/secure_downloads/92986/0/df1f59fc7ab45eb6692dbe9e0adecb4ad55cc2a4/18_04_23_Studie_Fezer_Repraesentatives_Dateneigentum_kas_52161-544-1-30.pdf (19.11.2019); Hoeren, Datenbesitz, statt Dateneigentum, MMR 2019, S. 5, 8.

- 57 Das Wikipedia-Zitat gibt zum einen die Stellung des Prosumers in der Energiewirtschaft wieder und zum andern auch sein Potenzial als «Co-Designer», https://de.wikipedia.org/wiki/Prosumer (20.11.2019).

- 58 Zuboff, The Age Of Surveillance Capitalism, 2019.

- 59 BVerfGE 49, 89, 114 – Kalkar I, in Erinnerung gerufen sei der Vortrag der Beschwerdeführer bei Kalkar I: «[...] der präventiven Personenüberwachung vor allem von Beschäftigten sowie deren Verwandten und Bekannten eine zunehmende Bedeutung zukommen. Sie reiche von der Erfassung persönlicher Daten und der Überwachung des Alltagslebens bis hin zur direkten Einschränkung der Lebensgewohnheiten. Es sei zu erwarten, daß die Sicherheitsanforderungen aus dem Bereich der Kernenergie auch auf andere industrielle Bereiche übertragen würden. Die Zahl der überwachten und kontrollierten Personen werde sich damit erheblich vergrößern und der notwendige Polizeiapparat entsprechend wachsen».

- 60 BVerfG, Urteil des Ersten Senats vom 06.12.2016 – 1 BvR 2821/11 – Atomkonsens II, Rn. 308: «[...] handelt es sich um die Beurteilung einer Hochrisikotechnologie, deren Schadensrisiken angesichts einer einerseits äußerst geringen Realisierungswahrscheinlichkeit und andererseits eines äußerst weitreichenden Ausmaßes etwaiger Schäden in besonderem Maße von einer politischen Bewertung und dabei in spezifischer Weise auch von einer öffentlichen Akzeptanz abhängig sind [...], kann auch Ereignissen ein eigenes Gewicht beigelegt werden, die, obwohl sie neue Gefährdungen nicht erkennen lassen, allein das Bewusstsein der Öffentlichkeit für diese Risiken ändern».

- 61 Inklusive von Unterlassungen.