1.

Einführung ^

Das Recht war eine der ersten Disziplinen, in der Information Retrieval (IR) zur Anwendung kam. Erste Anwendungen gab es bereits im Jahr 1960 [6]. Der Grund dafür ist offensichtlich: Die Juristerei ist eine textbasierte Disziplin. Information bildet das Fundament der juristischen Praxis. Heute ist jedoch die Stabilität und damit der Zugang zu juristischer Information in Gefahr. Die Auswirkungen der rapiden Zunahme der digitalen Veröffentlichung von Gerichtsentscheidungen wurde, zumindest für das anglo-amerikanische Recht, von Berring beschrieben: Schlecht geschriebene, unpräzise argumentierte oder schlicht unwichtige Gerichtsentscheidungen, die früher von den Redakteuren der juristischen Kommentare sowie Fachzeitschriften aussortiert worden wären, sind heute oft durch einfachen Mausklick abrufbar. Überflutung mit Information, insbesondere mit qualitativ minderwertiger Information, hat das Potential, das effiziente Funktionieren der Justiz zu gefährden. Eine Kernfrage dabei besteht darin, wie wir relevante von irrelevanten Gerichtsentscheidungen unterscheiden können. Wird es uns im Besonderen gelingen, eine neue Art des Umgangs mit digitaler Information zu entwickeln, welche die alten, autoritativen Referenzwerke und Kommentare ersetzen kann? Und können wird sicher sein, dass diese neuen Systeme robust genug sein werden, um ihren Benutzern auch rechtlichen Schutz zu gewähren? Rechtlichen Schutz in der Form, dass die Benutzer etwa als Anwälte nicht dem Vorwurf der Fahrlässigkeit (bei der Recherche) ausgesetzt sein können, wenn sie sich ausschließlich auf jene Fälle verlassen die ihnen das System empfohlen hat?

Modernes IR versucht sich diesen Herausforderungen zu stellen, es gilt jedoch noch viele Hürden zu überwinden. Juristisches IR besteht heute entweder aus textbasiertem Booleschen Retrieval, aus Wissensmodellierung (knowledge engineering, KE; eingesetzt beispielsweise beim «West Key Number System»), oder aus Bayes'schen Netzen. Keiner dieser drei Ansätze vermag sicherzustellen, dass zuverlässig und effizient alle, aber gleichzeitig auch nur die tatsächlich relevanten Fälle in einer Datenbank identifiziert werden. KE Ontologien modellieren erfolgreich, wie Juristen Präzedenzfälle identifizieren und in der Argumentation einsetzen − sie sind jedoch zu arbeitsintensiv, kostspielig und unflexibel. Blair und Maron [7] zeigen deutlich, dass Boolesches Retrieval die Erwartungen nicht einmal im Ansatz erfüllen kann: In ihrer berühmten Studie waren juristisch geschulte Anwender nicht in der Lage, mehr als 20% der tatsächlich relevanten Dokumente zu finden, während sie selbst glaubten, mindestens 75% der entsprechenden Dokumente gefunden zu haben. Kommerziell verfügbare juristische Bayes'sche Netze erreichen häufig weitaus bessere Ergebnisse als Boolesche Suchmaschinen [25], sind aber bei den Anwendern nichtsdestotrotz unbeliebt.

Eine Alternative zu KE basierten Ansätzen – die automatisierte Textanalyse – hat in Verbindung mit der Hyperlink-Analyse in offenen Domänen wie dem Internet einigen Erfolg erzielt. Bislang hat jedoch die juristische Informationstechnologiegemeinde diesem Feld wenig Aufmerksamkeit gewidmet. Der Grund für diese Vernachlässigung liegt unserer Auffassung nach darin, dass die diesen «Open Domain» Ansätzen zugrunde liegende Philosophie mit dem begrifflichen Denken des Juristen, seinen Erwartungen und seinem Selbstverständnis nur schwer in Einklang zu bringen ist: Dem Juristen wird schon in der Ausbildung klar gemacht, dass das richtige Ergebnis letztendlich weniger wichtig ist als eine überzeugende, explizite Argumentation. Methoden der Informationsgewinnung, die definitionsgemäß lediglich aus einer statistisch evaluierbaren «black box» bestehen, scheinen nicht in dieses Modell zu passen. Wir wollen eben nicht nur die richtigen Fälle ausgewählt erhalten, wir wollen auch nachvollziehen können, wie diese Auswahl getroffen wurde. Dies erklärt auch, warum juristische Anwender weiterhin auf manuell erstellte Ontologien zurückgreifen. Zum einen ist die automatisierte Suche derzeit noch nicht ausreichend schnell und zuverlässig, zum anderen scheinen NLP Technologien keine natürliche, intuitiv nachvollziehbare Entsprechung im Denken des Juristen zu haben. Wir argumentieren daher, dass juristische Begrifflichkeiten, Denkmuster und Faktoren auch weiterhin im juristischen IR eine Rolle spielen müssen, glauben aber gleichzeitig, dass die Ergebnisse des «Open Domain IR» (das «Phänomen Google») nichtsdestotrotz wichtige Beiträge zum juristischen IR leisten können. Erhöhte Effizienz reicht diesbezüglich nicht aus, um einen Paradigmenwechsel zu bewirken. Unser Beitrag versucht daher, Natural Language Processing im IR mit der kognitiven Begriffswelt des Juristen in Einklang zu bringen, sodass dieser Ansatz auch auf die rapide anwachsende Menge juristischer Information angewendet werden kann.

2.

Natural Language Processing und Information Retrieval ^

NLP basiertes IR erkennt an, dass es mehr als eine richtige Perspektive zur Organisation von Fallsammlungen geben kann, und betont jene spezifische Perspektive, die ein individueller Anwender zum Zeitpunkt seiner Suche gegenüber dem Material einnimmt. Dies unterscheidet diesen Zugang von jeder «autoritativen» Ordnung von Materialien, sei es ein traditioneller juristische Kommentar oder eine digitalen Referenzontologie. Unser Ansatz betont demgegenüber den rhetorischen Charakter juristischen Argumentierens. Da sich dieser Ansatz eng am tatsächlichen Text einer Entscheidung orientiert, ist er nicht der Gefahr ausgesetzt, die juristische Information zu verfälschen. Dies kann in den anderen genannten Ansätzen passieren, wenn zum Beispiel eine sehr präzise Nuance eines juristischen Begriffs aus der Referenzontologie herausgefallen ist und nicht formal repräsentiert wurde. Gleichzeitig wird vermieden, juristischen Begriffen über einen Zeitraum hinweg ungewollt stärkere oder schwächere Gewichtung in der Suche zu geben, je nachdem wo der Programmierer sie in der Begriffshierarchie eingebaut hat [12].

Erfolgreiche Implementierung von NLP-basiertem IR – wir verstehen darunter jedes System, das NLP Werkzeuge verwendet – hat sich bislang auch in der «Open Domain IR» Forschung (beispielsweise bei der Websuche) noch nicht völlig realisieren lassen. Stattdessen wird in der Regel statistisches IR, das ausschließlich einfache, generische Eigenschaften von Texten (wie zum Beispiel Zitationen oder Worte) als Ausgangspunkt nimmt, verwendet. NLP-basierte Suche, so unser Argument, ist gerade für die Suche nach juristischen Entscheidungen geeignet. Die formale, reglementierte Struktur juristischer Dokumente sollte die Anwendung von NLP Methoden erleichtern, die Anforderungen juristischer Anwender sollten sie darüber hinaus verlangen.

Von allen «Open Domain» Anwendungen ist die Suche nach juristischer Information der «question answering» Methodologie am verwandtesten. In der «Open Domain» Suche ist QA ein generelles Testmodell für fortgeschrittene semantische NLP Methoden, die flexibel genug sein müssen, um sehr verschiedene Arten von Suchanfragen zu unterstützen. «Question Answering» stellt in diesem Zusammenhang eine IR Methodologie dar, in der natürlichsprachliche Fragen des Anwenders automatisch in IR Suchanfragen übersetzt werden. Die erstenn Ergebnisse der resultierenden Suchanfrage werden dann je nach dem Vorhandensein von Fragetermen und anderen Faktoren angeordnet. Die Antwort wird dann wieder in natürlichsprachliche Sätze zurückübersetzt, sodass ein iterativer Dialog entsteht, durch den der Anwender seine Suche verfeinern, oder seine Unzufriedenheit mit dem Ergebnis ausdrücken kann [18].

Auch im Recht stellt sich die Kunst, die richtige Frage zu stellen, sehr viel flexibler dar als das Konzept der «korrekten Argumentation». Juristen entwickeln hochspezialisierte Fragetechniken etwa in der Erstberatung potentieller Klienten, und das Frage-Antwort Modell bildet in vieler Hinsicht den Kern der prozessualen Wahrheitsgewinnung [1,19]. Die Zeugenvernehmung ist das vielleicht typischste Beispiel für die Verwendung von Fragen zur Informationsgewinnung, viele andere prozessuale Vorgänge sind ebenfalls Frage-zentriert. Die Bedeutung des Konzepts der Frage hat mittlerweile auch bei Forschern in der künstlichen Intelligenz, die sich primär mit der Implementierung logisch zwingender Argumentation beschäftigen, Einzug gefunden. Wir sehen dies insbesondere in den Ansätzen von Walton und Gordon, und ihrer Verwendung von «critical questions» [27].

Wir argumentieren daher, dass die Kombination von Question Answering orientierten NLP Technologien mit existierenden Bayes'schen Netzen die Vorteile von NLP realisieren kann, und zugleich ein Modell der Informationssuche bereithält, das sogar noch mehr als wissensbasierte Systeme die juristische Methode und Denkweise reflektiert. Im nächsten Abschnitt werden wir diese beiden Ideen, NLP-Effizienz und juristische Begrifflichkeit, zusammenbringen. Die Konzepte der Genauigkeit («Precision») und Trefferquote («Recall») sind von zentraler Bedeutung in der Entwicklung und Evaluation von «Open Domain» IR, und die Notwendigkeit von Kompromissen zwischen beiden ist allgemein anerkannt. Beide werden bezüglich der noch bedeutenderen «Relevanz» gemessen. Im juristischen IR ist diese Annahme hingegen problematisch. Die adversatorische Natur des juristischen Prozesses führt dazu, dass ein IR System, das automatisch diejenigen Präzedenzfälle auswählt, die objektiv «am besten» zu der umstrittenen Situation passen (die im höchsten Grade «on-topic» sind), für eine der beiden Parteien ungeeignet sein wird. Deshalb schlagen wir vor, dass der Wunsch vieler juristischer Anwender für total recall problematisch ist, und dass diese vielmehr konzeptionellen oder kontextuellen recall innerhalb einer präzisierten Suche wollen. Wir illustrieren nun diese Idee durch eine graphische Darstellung, die zeigen soll, wie ein Jurist mental eine mögliche Suchsituation konzeptualisiert.

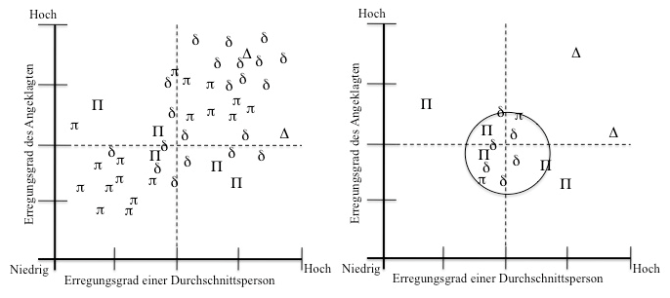

Abbildung 1. Die Verteilung der gefundenen Entscheidungen nach einem «total recall search» (a); nach einer Suche mit hohem recall im Kontext der Genauigkeit (b). Angelehnt an [22].

Abbildung 1a zeigt einen Graph, der von der Arbeit Suttons [22] inspiriert ist, und die Suche nach Entscheidungen für Mordfälle im Affekt abbildet. Dieser Graph repräsentiert das gedankliche Modell eines Juristen, wäre er voll über alle möglichen Präzedenzfälle, die für diesen Fall relevant sein könnten, informiert (total recall). In diesem Fall bezeichnetδ einen möglichen Präzedenzfall der im Sinne des Angeklagten, π einen Fall der im Sinne der Anklage entschieden wurde. ∆ und ∏ sind dabei jeweils die wichtigsten Fälle für die jeweilige Seite. Wir verstehen diesen Graphen als eine Abbildung von Gerichtsentscheidungen, wobei textuelle Ähnlichkeit der Sachlage durch räumliche Nähe im Ereignisraum repräsentiert wird, und die «entscheidenden Faktoren» – die rechtlich relevanten Fakten – die Einheiten auf den beiden Achsen darstellen. In diesem Fall sind dies Erregungsgrad einer Durchschnittsperson und Erregungsgrad des Angeklagten – wie nahe war die Reaktion des Angeklagten an einer «normalen» Antwort auf die Provokation, der er ausgesetzt war.

Dies entspricht auch unserer oben ausgedrückten Ansicht, dass im juristischen IR sowohl Sachlage als auch juristische Konzeptionalisierung berücksichtigt werden müssen. Wissensmodellierung und Wissensrepräsentation, juristische Konzepte und Entscheidungsfaktoren, entstehen durch die Debatte von Fakten. Aus diesem Grund haben mehrere Forscher die Bedeutung der Sachverhaltsbeschreibung für das juristische IR hervorgehoben [13, 14, 16]. Für unser Beispiel gehen wir davon aus, dass die juristischen Konzepte durch die Wissensmodellierung (KE) erzeugt wurden, und der relevante Kontext durch NLP extrahiert wurde.

Ein erfahrener Jurist wird in der Regel in der Lage sein, seine Erfolgsaussichten abzuschätzen, noch bevor er die Falldatenbank durchsucht hat. Nehmen wir an, dass in unserem Fall Anwalt X ziemlich sicher sein kann, dass es ausgezeichnete und relevante Präzedenzfälle für seine Seite gibt, während Jurist Y von vornherein weiß, dass er «nach Strohhalmen wird greifen müssen». Das Hauptinteresse von X besteht in dieser Situation darin, nur die aller bedeutsamsten Fälle, die «Standardentscheidungen» zu finden Diese kennt er entweder sowieso, oder er findet sie in einem der Standardkommentare. Oder er kann versuchen sie durch eine elektronische Suche in einer Rechtsdatenbank zu finden. In seinem Fall besteht das Hauptbedürfnis in Genauigkeit: Es gilt, diejenigen Entscheidungen zu finden, die hohe konzeptuelle Relevanz aufweisen (die juristisch operativen Fakten müssen sehr ähnlich sein). Eine mögliche geringe kontextuelle Relevanz (Eventualitäten) wird akzeptiert, weiters wird verlangt, dass die gefundenen Entscheidungen von hohem juristischen Wert sind (möglichst nur höchstgerichtliche sowie aktuelle Entscheidungen). Mit anderen Worten: Es sollen mithilfe der Suchbegriffe bedeutsame Entscheidungen gefunden werden (die juristische Dimension), die irgendwo im Ereignisraum liegen. Zustimmende Entscheidungen niedriger Gerichte, selbst wenn sie kontextuell sogar höhere Relevanz hätten, können ignoriert werden. Die strategische Verwendung von Entscheidungen in der juristischen Argumentation ist ein Qualitätsmerkmal des guten Juristen, und nur ein Anfänger würde in dieser Situation wirklich alle Entscheidungen zitieren (und riskieren, den Richter, der sie lesen muss, zu verärgern). Die Situation ist mit der Vernehmung eines Zeugens für die eigene Seite vergleichbar: Er soll ja nicht zu viel reden (das verwirrt den Zuhörer und erlaubt der Gegenseite Angriffe auf irrelevante Seitenbemerkungen) sondern sich nur kurz und präzise zur Sache äußern.

Für Jurist Y sieht die Situation anders aus, doch die Suchmaschine ist die gleiche. Ex hypothesis gibt es keine Entscheidungen höherer Gerichte für seine Seite, die eine wirklich vergleichbare Sachlage zum Inhalt hatten. Deshalb wird auch die Mehrheit der Entscheidungen der unteren Gerichte gegen ihn sein. Er hat nun zwei Möglichkeiten: Er kann versuchen, seinen Klienten zur Aufgabe zu bewegen, oder das Beste aus einer schwierigen Situation machen. Im letzteren Fall besteht seine beste Chance darin, die noch am ehesten relevante Entscheidung zu finden, selbst wenn sie von einem unteren Gericht kommt, oder in wichtiger Hinsicht von seinem aktuellen Fall abweicht. Jurist Y braucht irgendeine juristische Basis, um das Gericht dazu zu bewegen, die Argumentation der Gegenseite abzulehnen. Möglich sind eine gewagte Analogie zu einem anderen Rechtsgebiet (und damit unweigerlich zu einer Entscheidung, die anderes Vokabular und andere Begrifflichkeiten verwendet), je nach Verfügbarkeit eine «dissenting opinion» eines Kollegialgerichts, oder die Meinung eines vereinzelten Richters in erster Instanz, die später weder durch Berufung angegriffen noch durch die ständige Rechtsprechung aufgenommen wurde. Diese Texte könnten die Basis für ein Argument bilden, das das Gericht zu überzeugen versucht, aufgrund der Besonderheiten des aktuellen Falles eine andere Lösung als die zunächst «offensichtliche» zu wählen. Als Ergebnis ist die Datenbank für Jurist Y vergleichbar mit einem «hostile witness» Zeugen im Kreuzverhör. Die an den Zeugen gerichteten Fragen müssen verhindern, dass er faktisch korrekte aber nicht hilfreiche Information erhält. Jurist Y muss kleine Eingeständnisse oder übersehene Details finden, die ihm ein Gegenargument ermöglichen. Dies bringt uns zu einem Paradoxon, das zeigt, wie sich juristisches IR von der Suche nach wissenschaftlichen Dokumenten unterscheidet. Das Richtige ist nicht notwendigerweise das Beste, und je besser das IR System in der Identifizierung derjenigen Entscheidungen, die begrifflich und inhaltlich on topic sind sind, desto weniger hilft es Anwalt Y. Zur Lösung dieses Paradoxons schlagen wir vor, dass sowohl X als auch Y Vollständigkeit nur im Kontext der Genauigkeit wollen. Dieser Punkt ist entscheidend, und wird in Abbildung 1b ausgedrückt. Absolute Vollständigkeit würde beide Seiten in Material ertränken, das für ihre Zwecke irrelevant ist, wie Abbildung 1a zeigt. Stattdessen will Jurist X Vollständigkeit nur relativ zu einer präzisen Suche nach Fällen die hohe begriffliche Relevanz mit hohem juristischen Wert verbindet. Jurist Y hingegen braucht gerade diese Fälle nicht, er will Vollständigkeit für Fälle mit korrespondierenden Randbedingungen, kontextuelle, nicht konzeptionelle Ähnlichkeit. Dies verlangt eine andere Fragestrategie, in diesem Fall eine iterative Suche die die Tiefe des Ereignisraums durchsucht und den Kern weitgehend ignoriert.

3.

Schlussfolgerung ^

Dieser Beitrag hat sich auf zwei konkurrierende Ansätze des juristischen Information Retrievals konzentriert: manuelles, wissensbasiertes Retrieval − etwa durch formale Ontologien − sowie natürlichsprachliches Information Retrieval (NLP). Wir haben argumentiert, dass das erstere Modell langfristig nicht den wandelnden Anforderungen des Juristen gewachsen ist. Oberflächlich betrachtet scheinen NLP Ansätze die spezifischen Fähigkeiten, das Vorwissen und die Denkweise des Juristen nicht ausreichend auszunützen. Doch durch die Verbindung von NLP mit fragebasierten Ansätzen zum IR haben wir gezeigt, wie die natürlichsprachliche Informationssuche mit Kernkompetenzen des Juristen in Einklang gebracht werden kann. Wir haben das Spannungsverhältnis von Vollständigkeit und Relevanz als Beispiel verwendet, um das Potential unseres Ansatzes zu verdeutlichen. Seit der Arbeit an diesem Beitrag haben wir eine Implementierung dieser Idee entwickelt, und mit der empirischen Evaluierung begonnen. Erste Ergebnisse zeigen, dass jedenfalls die technische Genauigkeit der Suche durch diese Vorgehensweise erhöht werden kann. Eine Evaluierung mithilfe tatsächlicher Falldatenbanken sowie juristischen Suchproblemen steht allerdings noch aus.

4.

Literatur ^

[1] K.D. Ashley und V. Aleven. Toward an intelligent tutoring system for teaching law students to argue with cases. In Proceedings of ICAIL 1991, 1991.

[2] R.C. Berring. Full-text databases and legal research: Backing into the future. High Tech. Law J., 1:27–60, 1986.

[3] R.C. Berring. Finding the law. West Publishing Co., 1995.

[4] R.C. Berring. The heart of legal information: The crumbling infrastructure of legal research. In R.A. Danner and F.G. Houde, editors, Legal information and the development of American law. St. Paul, MN : Thomson/West, 2008.

[5] C. Biagioli, E. Francesconi, A. Passerini, S. Montemagni, und C. Soria. Automatic semantics extraction in law documents. In Proceedings of ICAIL 2005, 2005.

[6] J. Bing. Performance of legal text retrieval systems: The curse of Boole. Law Libr. J., 79:187–202, 1987.

[7] D.C. Blair und M.E. Maron. An evaluation of retrieval effectiveness for a full-text document-retrieval: An evaluation of retrieval effectiveness for a full-text document-retrieval system. Comm. ACM, 28(3):289–299, 1985.

[8] S. Brüninghaus und K.D. Ashley. Using machine learning for assigning indices to textual cases. In Proceedings of ICCBR 1997, 1997.

[9] S. Brüninghaus und K.D. Ashley. Improving the representation of legal case texts with information extraction methods. In Proceedings of ICAIL 2005, 2001.

[10] D.P. Dabney. The curse of thamus: An analysis of full-text legal document retrieval. Law Libr.J. , 78:5–40, 1986.

[11] D.P. Dabney. Statistical Modeling of Relevance Judgments for Probabilistic Retrieval of American Case Law. PhD thesis, University of California, Berkeley, 1993.

[12] D.P. Dabney. The universe of thinkable thoughts: Literary warrant andWest’s Key Number system. Law Libr. J., 229, 2007.

[13] J.P. Dick. Representation of legal text for conceptual retrieval. In Proceedings of ICAIL 1991, pages 244–253, 1991.

[14] D. Gelbart und J.C. Smith. Beyond Boolean search: Flexicon, a legal text-based intelligent system. In Proceedings of ICAIL 1991, pages 225–234, 1991.

[15] K. Gerson. Evaluating legal information retrieval systems: How do the ranked retrieval methods of Westlaw and lexis measure up? Legal References Services Quarterly, 17(4):53–68, 1999.

[16] C.D. Hafner. Conceptual organization of case law knowledge bases. In Proceedings of ICAIL 1987, pages 35–42, 1987.

[17] M.-F. Moens and R. De Busser. First steps in building a model for the retrieval of court decisions. Int. J. Hum. Comput. Stud., 57(5): 429–446, 2002.

[18] S. Narayanan and S. Harabagiu. Question answering based on semantic structures. In Proceedings of COLING, page 693, 2004.

[19] M.L. Perlin. Competence in the law: from legal theory to clinical application. John Wiley & Sons, 2008.

[20] M.L. Silveira und B. Ribeiro-Neto. Concept-based ranking: a case study in the juridical domain. Information Processing and Management, 40(5):791–805, 2004.

[21] J.C. Smith. The use of lexicons in information retrieval in legal databases. In Proceedings of ICAIL, pages 29–38, 1997.

[22] S.A. Sutton. The role of attorney mental models of law in case relevance determinations: an exploratory analysis. J. Am. Soc. Inform. Sci., 45(3): 186–200, 1994.

[23] S. Tomlinson, D.W. Oard, J.R. Baron, and P. Thompson. Overview of the TREC 2007 Legal Track. In Proceedings of the 16th Text Retrieval Conference, 2007.

[24] H.R. Turtle. Inference Networks for Document Retrieval. PhD thesis, University of Massachusetts, 1991.

[25] H.R. Turtle. Natural language vs. boolean query evaluation: a comparison of retrieval performance. In Proceedings of SIGIR, pages 212–220, 1994.

[26] H.R. Turtle. Text retrieval in the legal world. Artif. Intell. Law, 3(1–2): 5–54, 1995.

[27] D. Walton und T.F. Gordon. Critical questions in computational models of legal argument. In P.E. Dunne and T. Bench-Capon, editors, International Workshop on Argumentation in Artificial Intelligence and Law, pages 103–111, 2005.

Tamsin Maxwell, School of Informatics, University of Edinburgh, t.maxwell@ed.ac.uk

Burkhard Schafer, School of Law, SCRIPT, University of Edinburgh, Old College, EH8 9YL, b.schafer@ed.ac.uk

Anton Geist gebührt herzlicher Dank für die erforderliche Verbesserung der österreichisch-deutschen Version dieses Beitrags.